强化学习(RL)中样本复杂性高的一个关键原因是无法将知识从一个任务转移到另一个任务。在标准的多任务RL设置中,在尝试解决一个任务时收集的低报酬数据为解决该特定任务提供的信号很少甚至没有,因此实际上被浪费了。然而,我们认为,对于一项任务来说,这些数据是没有信息的,但对于其他任务来说,这可能是一个丰富的信息来源。为了利用这种洞察力并有效地重用数据,我们提出了广义后见:一种近似的反向强化学习技术,用于用正确的任务重新标记行为。直观地说,给定在一个任务下生成的行为,Generalized Hindsight会返回一个不同的任务,该行为更适合该任务。然后,在被非策略RL优化器使用之前,用这个新任务重新标记该行为。与标准的重新标记技术相比,广义后视提供了更有效的样本重用,我们在一组多任务导航和操纵任务上进行了实证验证。

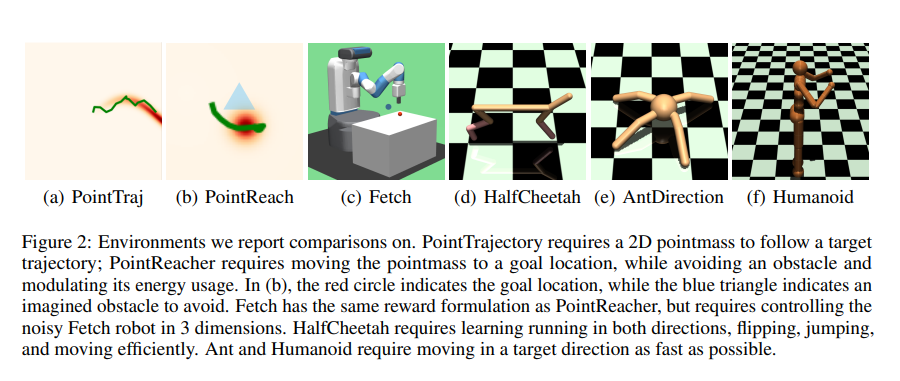

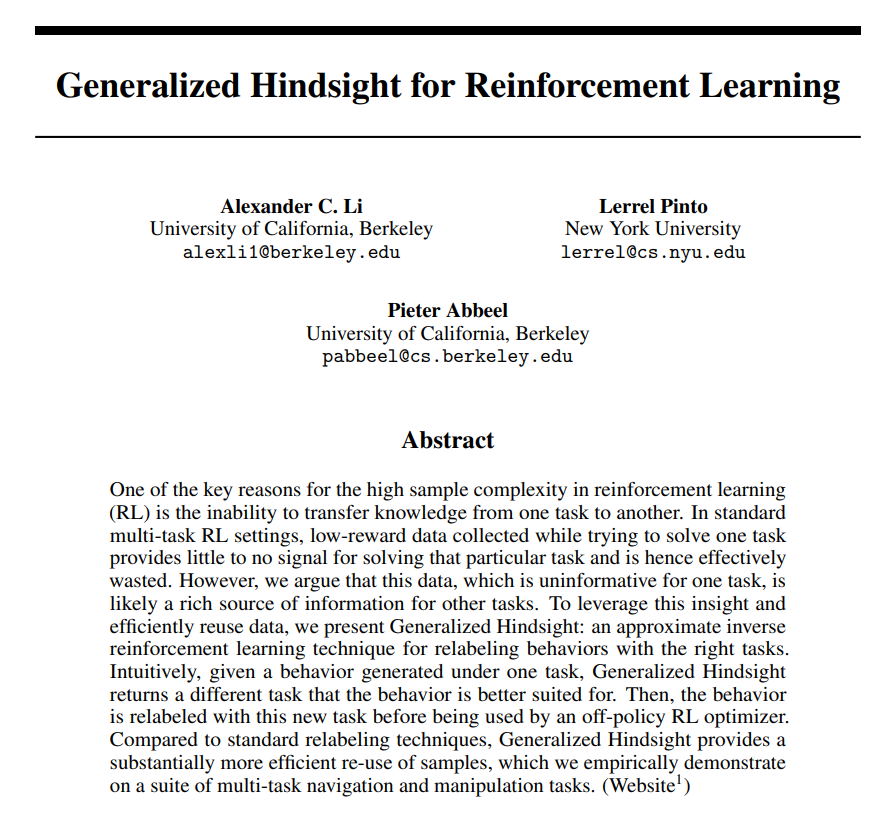

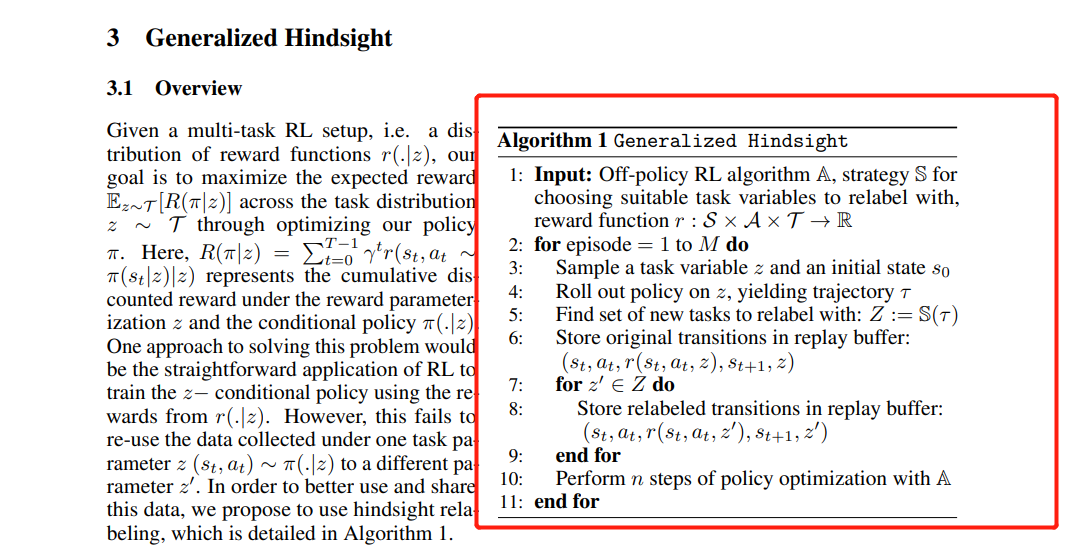

无模型强化学习(RL)结合强大的函数逼近器在雅达利[43]和围棋[64]等游戏以及行走[24]和飞行[33]等控制任务中取得了显著的成功。然而,这些方法的一个关键限制是它们的样本复杂性。他们通常需要数百万样本来学习简单的运动技能,有时甚至需要数十亿样本来学习更复杂的游戏策略。创建通用代理将需要学习多种这样的技能或策略,这进一步加剧了这些算法的效率低下。另一方面,人类(或生物制剂)不仅能够学习多种不同的技能,而且能够从数量级更少的样本中学习[32]。那么,我们如何赋予RL代理跨多个任务高效学习的能力?生物学习的一个关键特征是从错误中学习的能力。在RL中,在解决任务时所犯的错误仅用于指导特定任务的学习。但在犯这些错误时看到的数据往往包含更多信息。事实上,提取和重用这些信息是最有效的RL算法的核心。基于模型的RL重新使用该信息来学习环境的动力学模型。然而,对于几个领域,学习稳健模型通常比直接学习政策更困难[15],解决这一挑战仍然是一个活跃的研究领域[46]。重用低报酬数据的另一种方法是非策略RL,与策略RL相反,在优化新策略的同时重用从旧策略收集的数据。但在多任务学习的背景下,这仍然是低效的,因为从一个任务生成的数据不能有效地通知另一个任务。为了解决这个问题,Andrychowicz等人[2]的工作重点是通过事后观察提取更多信息。在目标条件设置中,任务由稀疏目标定义,后视体验回放(HER)[2]将生成轨迹的期望目标重新标记为该轨迹中看到的状态。因此,如果以目标为条件的策略错误地达到了错误的目标,而不是期望的目标,我们可以重新使用这些数据来教它如何达到这个错误的目标。因此,一个期望目标下的低奖励轨迹被转换为非期望目标的高奖励轨迹。这种新的重新标记提供了强有力的监督,并大大加快了学习速度。然而,在这个框架中做出的一个关键假设是,目标是需要达到的一组稀疏的状态。这允许通过简单地为政策访问的州设置重新标记的目标来有效地重新标记。但对于一些现实世界中的问题,如节能运输或机器人轨迹跟踪,回报往往是理想的复杂组合,而不是稀疏的目标。那么,我们如何对奖励功能的一般家族使用事后诸葛亮呢?在本文中,我们基于目标条件后见的思想,提出了广义后见。在这里,我们不是对稀疏目标的任务族进行事后观察,而是对奖励函数的任务族执行事后观察。由于密集的奖励功能可以捕获更丰富的任务规范,GH允许更好地重新利用数据。请注意,这与解决由奖励函数族引起的任务分配一起完成。然而,为了重新标记,我们现在需要计算最能解释生成数据的奖励函数,而不是简单地将访问状态设置为目标。为此,我们从反向强化学习(IRL)中提取联系,并提出一种近似IRL重新标记算法,我们称之为AIR。具体来说,AIR采用了一个新的轨迹,并将其与我们分布的K个随机采样任务进行了比较。它选择轨迹为“伪演示”的任务,即轨迹在该任务中的性能高于我们之前的任何轨迹。然后,可以使用该“伪演示“快速学习如何执行该新任务。我们在图1中说明了该过程。我们在几个多任务控制任务上测试了我们的算法,并发现AIR始终以少至20%的环境交互作为基线来实现更高的渐近性能。我们还引入了一个计算效率更高的版本,通过将轨迹奖励与学习的基线进行比较来重新标记,这也实现了比基线更高的渐近性能。总之,我们在本文中提出了三个关键贡献:(a)我们将后见之明的思想扩展到广义奖励家庭设置;(b) 我们提出了AIR,一种使用IRL见解的重新标记算法。[17]中同时独立地研究了这一联系,并在第4.5节中进行了额外讨论;(c) 我们在一套多任务导航上展示了多任务RL的显著改进