多智能体强化学习在实践中受到越来越多的关注,例如机器人和自动驾驶,因为它可以使用与环境交互生成的样本来探索最优策略。然而,当我们想要训练一个令人满意的模型时,高回报的不确定性仍然是一个问题,因为获得高质量的回报反馈通常是昂贵的,甚至是不可行的。为了解决这个问题,以前的方法主要集中在被动奖励纠正上。与此同时,最近的主动报酬估计方法已被证明是减少报酬不确定性影响的一种方法。本文提出了一种新的分布式报酬估计框架,用于有效的多Agent强化学习(DRE-MARL)。我们的主要思想是设计用于稳定训练的多动作分支奖励估计和策略加权奖励聚合。具体地说,我们设计了多动作分支的报酬估计,以对所有动作分支上的报酬分布进行建模。然后在训练过程中利用奖励聚合来获得稳定的更新信号。我们的直觉是,考虑行动的所有可能后果对学习政策是有用的。在有效性和鲁棒性方面,与SOTA基线相比,DRE-MARL的优势通过基准多代理场景得到了证明。

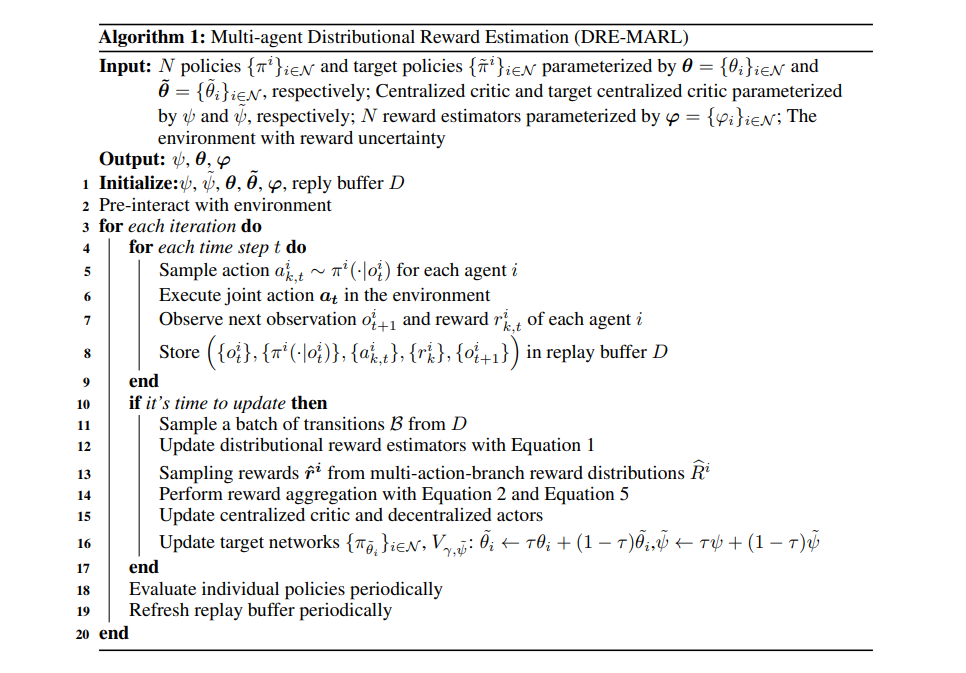

多智能体强化学习(MARL)在解决实时竞争游戏[30]、机器人操纵[1]、自主交通控制[32]和定量交易策略[15]方面取得了巨大成功。大多数现有的作品都要求代理人接受高质量的监督信号,即奖励,这在实践中既不可行,也很昂贵[61]。环境提供的奖励受到多种随机性的影响。例如,从机器人上的传感器收集到的奖励将受到温度和照明等物理条件的影响,这使得奖励充满偏见和内在随机性。代理人之间的相互作用将导致更多的报酬不确定性。例如,尽管一个代理在相同的状态下执行相同的操作,但由于其他代理可以执行其他操作,因此奖励仍然可能不同。因此,在学习过程中处理非平稳奖励是在多智能体环境中成功学习复杂行为的必要条件。事实上,在强化学习(RL)中,有许多研究[23,28,61,60]考虑了训练过程中的奖励不确定性。对非平稳反馈的传统研究主要集中在被动奖励修正上。例如,Wang等人[60]采用混淆矩阵来建模奖励不确定性,并获得稳定的学习奖励。在[61]中,作者用同级损失恢复了真实的监管信号,这惩罚了避免过度匹配的过度协议。然而,上述作品报酬不确定性的假设是有限制的。例如,奖励翻转机制[60]将奖励的随机性限制为一个可计数的值集。最近,另一系列研究集中在主动报酬估计上。为了缓解奖励不确定性问题,一些工作将奖励估计视为一个点对点回归问题,其中每个状态-动作对都映射到一个奖励[38,64]。然而,MARL中的点对点报酬估计并不能完全解决报酬的不确定性,特别是由代理人的相互作用引起的报酬不确定性。这是因为回归擅长于状态和奖励之间的一对一映射。但在MARL中,一个代理的相同状态-动作对输入将导致多重环境奖励(即一对多映射),这对于回归来说是难以解决的,因此会影响性能。此外,这些方法没有考虑到报酬不确定性不仅来自于固有的环境随机性,而且来自于代理人之间的相互作用。这两个因素对获得的奖励产生混合影响,增加了训练难度。如我们稍后的实验所示(详见图3(左)),这种点对点策略会随着代理数量和奖励不确定性程度的增加而导致更糟糕的次优结果[31]。在这项工作中,我们的目标是发展MARL的分配报酬估计,然后是政策加权报酬聚合。直觉上,我们的想法就像一个人在大脑中构建了一个所有行动分支的奖励蓝图,并通过考虑所有可能的后果来深思熟虑地做出决定。传统方法[27,41]只使用环境奖励来评估政策,这在培训批评者时会带来更多的不确定性,因为它们只考虑在采取特定行动(即第k次行动ak)后收到的奖励rk。在我们的方法中,我们不仅考虑环境奖励,还考虑其他动作分支的潜在奖励,以执行更稳定的批评者更新,从而获得更好的表现。因此,我们提出了多动作分支分配报酬估计,以对所有动作分支上的报酬分布{R∞i(oi,aik)}k=1进行建模,其中o i t是观察值,a i k,t是第k个动作。然后,我们通过根据当前策略的相应行动选择概率对环境奖励rk和从不同行动分支分布{Ræi(oi,ai m)}K m=1,m6=K中采样的奖励进行加权,从而将它们聚合在一起。我们将获得通过奖励聚合对每个代理人进行培训的聚合混合奖励R³i和集总奖励R³i。奖励聚合使代理人能够深思熟虑地评估其历史决策,从而提供了一种复杂而有效的方法来减少奖励不确定性的影响。这种模型涵盖了MARL环境中的奖励不确定性,并在从小到大的代理数量的多个MARL基准测试中实现了更好的性能。我们的贡献是三方面的。1) 我们提出了一个新的框架,称为多代理分配报酬估计(DRE-MARL),通过对所有行动分支的报酬分配建模,系统地描述MARL中的报酬不确定性。据我们所知,这是第一次尝试用多行动分支分配规则解决MARL的报酬不确定性

@* Jifeng Hu, Yanchao Sun, Hechang Chen, Sili Huang, haiyin piao, Yi Chang, Lichao Sun: “Distributional Reward Estimation for Effective Multi-Agent Deep Reinforcement Learning”, 2022; [http://arxiv.org/abs/2210.07636 arXiv:2210.07636].