我们介绍了一个将强化学习(RL)抽象为序列建模问题的框架。这允许我们利用Transformer架构的简单性和可扩展性,以及GPT-x和BERT等语言建模方面的相关进展。特别是,我们提出了决策变压器,一种将RL问题转化为条件序列建模的架构。与以前的RL方法(拟合值函数或计算策略梯度)不同,Decision Transformer仅通过利用因果掩蔽的Transformer来输出最佳操作。通过对期望回报(回报)、过去状态和行为进行自回归模型,我们的决策变压器模型可以生成实现期望回报的未来行为。尽管它很简单,但Decision Transformer在Atari、OpenAI Gym和Key to Door任务上的性能与最先进的无模型离线RL基线相匹配或超过。

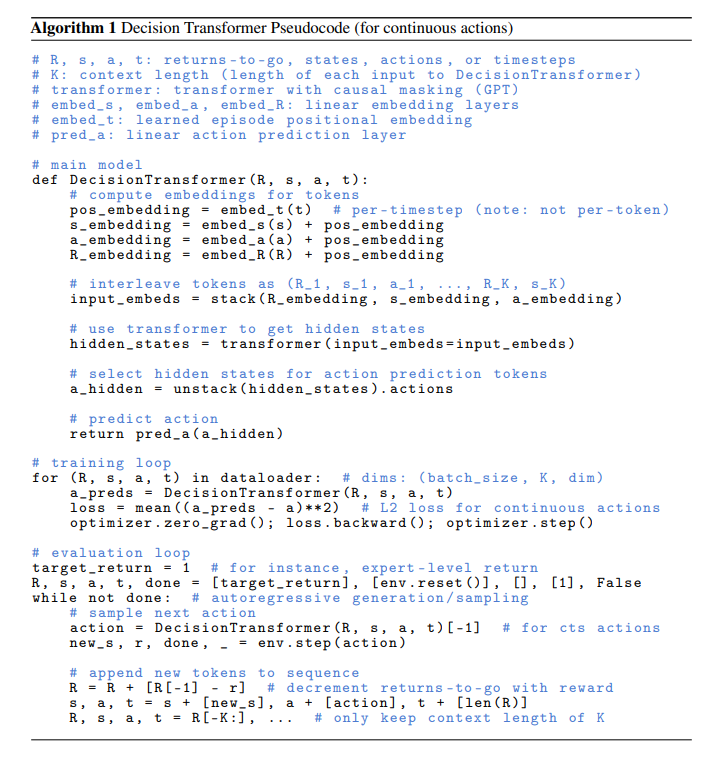

最近的工作表明,变形金刚[1]可以对语义概念的大规模分布进行建模,包括语言中的零镜头泛化能力[2]和令人印象深刻的分布外图像生成[3]。这与强化学习(RL)中的许多工作形成了鲜明的对比,后者学习单个策略来建模特定的狭义行为分布。鉴于应用的多样性和变压器模型的影响,我们试图研究它们在顺序决策问题中的应用。特别是,我们试图研究轨迹建模(类似于语言建模)是否可以替代传统的RL算法,而不是将变换器作为传统RL算法的架构选择[4,5]。我们考虑以下范式转变:我们将使用序列建模目标,根据收集的经验训练变压器模型,而不是通过传统RL算法(如RL中的主导范式——时间差分(TD)学习[6])训练策略。这将允许我们绕过引导传播回报的需要,从而避免已知的破坏RL稳定的“致命三合会”[6]之一。它还避免了像TD学习中通常做的那样,对未来奖励进行贴现的必要性,因为这会导致不良的短视行为。此外,我们可以利用现有的变压器框架,这些框架广泛用于易于扩展的语言和视觉,利用大量研究变压器模型稳定训练的工作;这种方法通过只吸引普通的监督学习系统,消除了对专门的RL框架的需要。鉴于变压器已被证明具有建模长序列和宽数据分布的能力,变压器还具有其他优势。变形金刚可以通过自我关注直接执行信用分配,与贝尔曼备份相比,贝尔曼备份缓慢传播奖励,容易产生“分心”信号[7]。这可以使变形金刚在奖励稀少或分散注意力的情况下仍能有效工作。此外,变压器建模方法可以对广泛分布的行为进行建模,从而实现更好的泛化和传递。虽然“倒置”强化学习(UDRL)[8,9,10]也使用以目标回报为条件的监督损失,但我们的工作是由序列建模而非监督学习推动的,并寻求从建模长序列行为中受益。有关相关工作的更多讨论,请参见第6节。我们通过考虑离线RL来探索我们的假设,在离线RL中,我们将任务代理从次优数据中学习策略——从固定的、有限的经验中产生最大有效的行为。由于错误传播和价值高估,这项任务传统上具有挑战性[11]。然而,当以序列建模目标进行训练时,这是一项自然的任务。通过训练一个关于状态、行动和回报序列的自回归模型,我们将政策抽样减少为自回归生成模型。我们可以通过手动设置返回令牌来指定策略的专业知识,即要查询的“技能”,作为生成提示。