基于价值函数的强化学习(RL)算法,例如Qlearning,从行动、奖励和状态转换的数据集学习最优策略。然而,当潜在的状态转移动力学是随机的并且在高维空间上演化时,由于相关的归一化积分的难处理性,生成独立的相同分布(IID)数据样本来创建这些数据集是一个重大挑战。在这些场景中,哈密顿蒙特卡罗(HMC)采样提供了一种计算上易于处理的方法来生成用于训练RL算法的数据。在本文中,我们引入了一个称为哈密顿Q学习的框架,该框架从理论和经验上证明了Q值可以从HMC动作、奖励和状态转换样本生成的数据集中学习。此外,为了利用Q函数的底层低秩结构,哈密顿Q学习使用矩阵完成算法来从状态动作对的小得多的子集上的Q值更新重建更新的Q函数。因此,通过提供一种在随机、高维设置中应用Q学习的有效方法,所提出的方法拓宽了RL算法在真实世界应用中的范围。

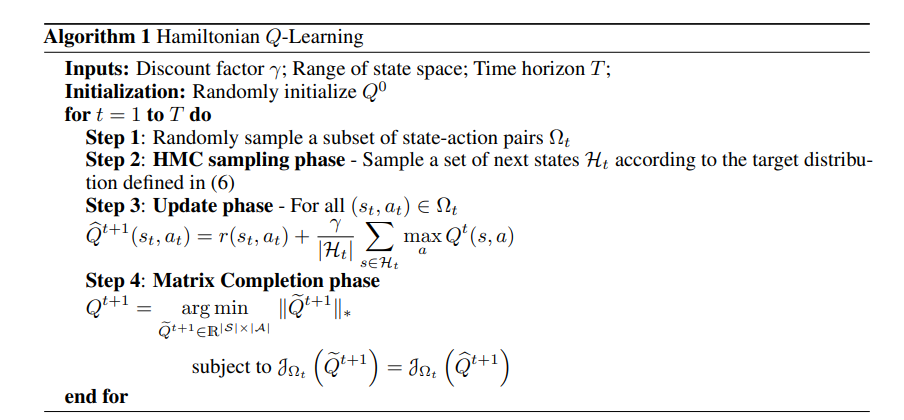

近年来,强化学习在顺序决策任务中取得了显著的成功,其中主体在观察到环境的当前状态后,选择一个动作来获得奖励,随后环境转换到新的状态[1,2]。RL已应用于各种问题,如自动控制[3]、机器人[4]、资源分配[5]和化学过程优化[6]。然而,现有的无模型RL方法通常只有在对环境进行了足够长的探索时才表现良好,并且算法在过程中使用了大量样本[7,8]。Q学习是一种无模型RL方法,其中代理基于由状态动作值函数(即Q函数)定义的策略来选择其动作[9,10]。Q学习算法的性能在很大程度上取决于访问数据样本的能力,这可以提供对预期Q值的准确估计。当这些算法通过计算一组IID样本上Q值的样本平均值来计算预期Q值时,它们假设可以访问模拟器,该模拟器可以根据状态转移概率生成IID样本。然而,当状态转移概率分布为高维时,由于(i)缺乏闭合形式的解,以及(ii)归一化积分的确定性近似不足,阻止了现有RL方法的使用,生成IID样本会带来重大挑战。这促使我们提出一个问题:当生成IID样本不可行时,我们如何开发基于价值函数的RL方法?开发这种方法的关键步骤是确定从非正规分布中提取样本的方法。重要性抽样方法提供了从分布中抽取样本的技术,而无需计算相应的归一化积分。Hamilton Monte Carlo(HMC)采样就是这样一种方法;它允许人们从非正规化状态转变分布中生成样本[11]。配备了HMC,我们试图回答以下问题:我们如何将HMC采样与Q-Learning相结合,以学习高维问题的最优策略?在这项工作中,我们引入哈密顿Q学习来回答这个问题。我们表明,即使哈密顿Q学习使用HMC样本而不是IID样本来计算期望的Q值,它也可以推断最优策略。现在,尽管HMC样本克服了与高维绘制IID样本相关的挑战,但仍需要大量样本来学习Q函数,因为高维空间通常会导致大量状态动作对。我们通过利用矩阵完成技术来解决这个问题。已经观察到,在各种问题中制定规划和控制任务,如视频游戏(如雅达利游戏)和经典控制问题(如单摆、推车杆)作为Q学习问题,导致与问题相关的Q矩阵中的低阶结构[12,13,14]。由于这些系统自然地由大量状态组成,以知情的方式利用Q矩阵中的低秩结构可以进一步降低计算复杂度。哈密顿Q学习使用矩阵补全来从期望Q值的一个子集中重构Q矩阵,使其具有数据效率。这项工作的三个主要贡献是三方面的。首先,我们介绍了一种改进的Q学习框架,称为哈密顿Q学习,它使用HMC采样来有效计算Q值。这一创新,通过提议从对折扣奖励期望有主导贡献的区域中采样Q值,为在具有高维状态空间和概率状态转换的现实问题中使用Q学习提供了一种数据高效的方法。将这种采样方法与矩阵完成相结合,使我们能够仅更新状态动作对的一小部分的Q值,并重构完整的Q矩阵。其次,我们提供了理论保证,通过使用HMC采样更新Q值计算出的最优Q函数和Q函数之间的误差可以任意小。即使当仅使用HMC样本更新Q值的一小部分并且使用矩阵完成来估计其余值时,该结果仍然成立。我们还提供了理论保证,我们算法的采样复杂度与[15]提出的最小-最大采样复杂度相匹配。最后,我们将哈密顿Q学习应用于高维问题(特别是稳定小车上的双摆问题)以及基准控制任务(倒立摆、双积分器、小车和机器人)。我们的结果表明,随着状态空间维数的增加,所提出的方法变得更加有效。