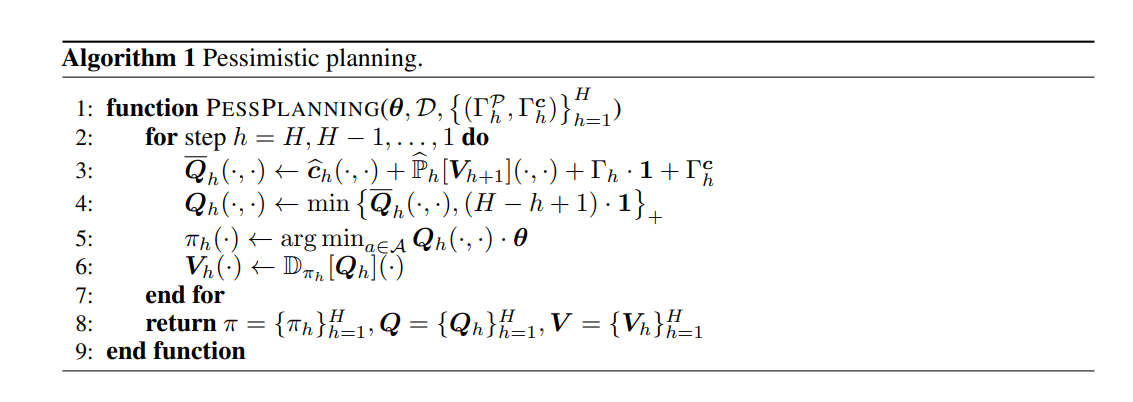

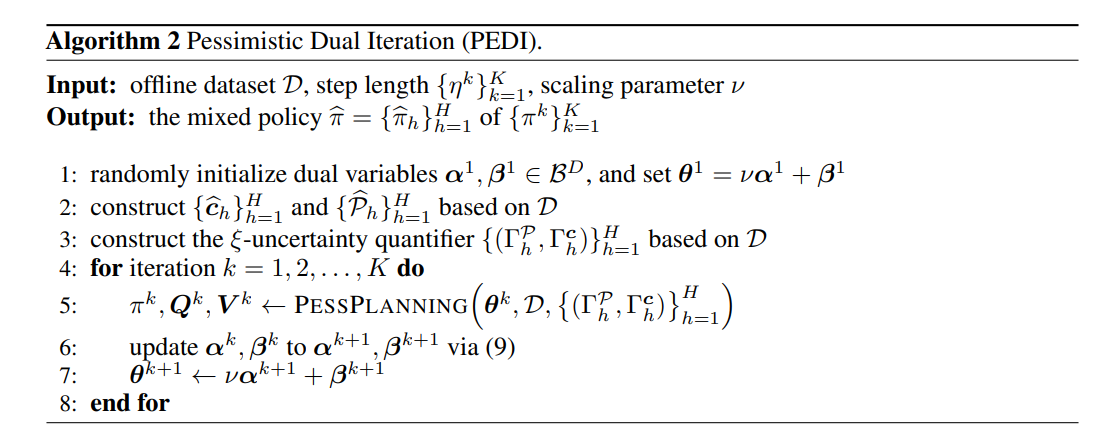

在约束多目标RL中,目标是学习一种策略,该策略在约束下实现由多目标偏好函数指定的最佳性能。我们关注离线设置,其中RL智能体旨在从给定的数据集中学习最佳策略。这种情况在现实应用程序中很常见,在这些应用程序中,与环境的交互是昂贵的,违反约束是危险的。对于这样的设置,我们将原始约束问题转化为原始对偶公式,通过对偶梯度上升来解决。此外,我们建议将这种方法与悲观主义相结合,以克服离线数据中的不确定性,这导致了我们的悲观对偶迭代(PEDI)。我们基于任意数据集为PEDI学习的策略建立了次优和违反约束的上界,这证明了PEDI是可证明的样本有效的。我们还将PEDI专门用于具有线性函数近似的设置。据我们所知,我们提出了第一个具有离线数据的可证明有效的约束多目标RL算法,而不需要对数据集的覆盖率进行任何假设。

近年来,人们对多目标RL越来越感兴趣。与传统的单目标RL相比,多目标RL的目标依赖于一个偏好函数,该函数以多个目标为输入,输出一个标量。多目标优化问题通常是受约束的,否则可能会在应用中造成危险或故障。例如,考虑一个家庭自动化系统,它可以帮助人们监视和控制可以被视为多目标的家庭属性。不同时间的用户可能会重视其服务的不同方面。有些人可能会高度重视夜间照明,而另一些人可能会关注气候。我们可以将用户的偏好表述为多个目标上的偏好函数。因此,该系统正在处理一个多目标优化问题。然而,系统无法在没有任何约束的情况下优化这个问题,这可能违背人类的意愿,例如在房屋内产生极端气候或执行不可接受的耗能操作。我们制定了约束多目标马尔可夫决策过程(CMOMDP),它类似于约束马尔可夫决定过程(CMDP)(Altman,1999)。不同的是,目标是多重的,约束可以是非线性的。我们的目标是最小化偏好函数的值,该函数将多个目标作为输入并输出一个标量。

大多数现有的RL方法都假定代理可以完全访问环境,这往往是不切实际的,因为勘探可能很昂贵(Gottesman等人,2019),也很危险(ShalevShwartz等人,2016)。因此,我们考虑离线情况,其中代理只有预先收集的历史数据集,并且没有与环境的进一步交互。这种设置很常见,并体现在各种场景中,如医疗保健(Chakraborty和Murphy,2014)和自动驾驶(Sun等人,2020)。然而,理论上对离线RL的理解较少