机器人变压器2(RT-2)是一种新颖的视觉-语言-行动(VLA)模型,它从网络和机器人数据中学习,并将这些知识转化为机器人控制的通用指令。

高容量视觉语言模型(VLM)在网络规模的数据集上进行训练,使这些系统非常擅长识别视觉或语言模式并跨不同语言运行。但是,要使机器人达到类似的能力水平,它们需要收集机器人数据,第一手资料,包括每个对象,环境,任务和情况。

在我们的论文中,我们介绍了机器人变压器2(RT-2),这是一种新颖的视觉 - 语言 - 行动(VLA)模型,可以从Web和机器人数据中学习,并将这些知识转化为机器人控制的通用指令,同时保留Web规模功能。

在网络规模数据上预先训练的视觉语言模型(VLM)正在从RT-1机器人数据中学习,成为RT-2,一种可以控制机器人的视觉语言行动(VLA)模型。

这项工作建立在机器人变压器1(RT-1)的基础上,这是一个在多任务演示中训练的模型,可以学习机器人数据中看到的任务和对象的组合。更具体地说,我们的工作使用了RT-1机器人演示数据,这些数据是在办公室厨房环境中用13个机器人在17个月内收集的。

RT-2显示出改进的泛化能力以及语义和视觉理解,超出了它所接触到的机器人数据。这包括解释新命令并通过执行基本推理来响应用户命令,例如对对象类别或高级描述进行推理。

我们还表明,结合思维链推理允许RT-2执行多阶段语义推理,例如决定哪个物体可以用作临时锤子(岩石),或者哪种类型的饮料最适合疲惫的人(能量饮料)。

使VLM适应机器人控制

RT-2 基于将一个或多个图像作为输入的 VLM 构建,并生成一系列标记,这些标记通常表示自然语言文本。此类 VLM 已在网络规模数据上成功训练以执行任务,例如视觉问答、图像字幕或对象识别。在我们的工作中,我们调整了Pathways语言和图像模型(PaLI-X)和Pathways语言模型Embodied (PaLM-E)作为RT-2的骨干。

要控制机器人,必须训练它输出动作。我们通过在模型输出中将操作表示为标记(类似于语言标记)来应对这一挑战,并将操作描述为可由标准自然语言标记器处理的字符串,如下所示:

RT-2 训练中使用的操作字符串的表示形式。这种字符串的一个例子可以是机器人动作令牌编号序列,例如“1 128 91 241 5 101 127 217”。

该字符串以指示是继续还是终止当前情节的标志开头,而不执行后续命令,然后是更改末端执行器位置和旋转的命令,以及机器人抓手的所需延伸。

我们使用与RT-1相同的离散化版本的机器人动作,并表明将其转换为字符串表示使得在机器人数据上训练VLM模型成为可能 - 因为此类模型的输入和输出空间不需要更改。

RT-2架构和训练:我们在机器人和Web数据上共同微调预先训练的VLM模型。生成的模型接收机器人相机图像,并直接预测机器人要执行的动作。

概括和紧急技能

我们在 RT-2 模型上进行了一系列定性和定量实验,进行了 6,000 多次机器人试验。在探索RT-2的新兴能力时,我们首先搜索了需要将网络规模数据和机器人经验相结合的任务,然后定义了三类技能:符号理解,推理和人类识别。

每项任务都需要理解视觉语义概念以及执行机器人控制以对这些概念进行操作的能力。诸如“捡起即将从桌子上掉下来的袋子”或“将香蕉移动到二加一的总和”之类的命令 - 其中机器人被要求对机器人数据中从未见过的物体或场景执行操作任务 - 需要从基于网络的数据转换的知识才能操作。

机器人数据中不存在的新兴机器人技能示例,需要从网络预训练中转移知识。

在所有类别中,我们观察到与以前的基线相比,泛化性能有所提高(提高3倍以上),例如以前的RT-1模型和Visual Cortex(VC-1)等模型,这些模型是在大型视觉数据集上预先训练的。

紧急技能评估的成功率:我们的RT-2模型优于以前的机器人变压器(RT-1)和视觉预训练(VC-1)基线。

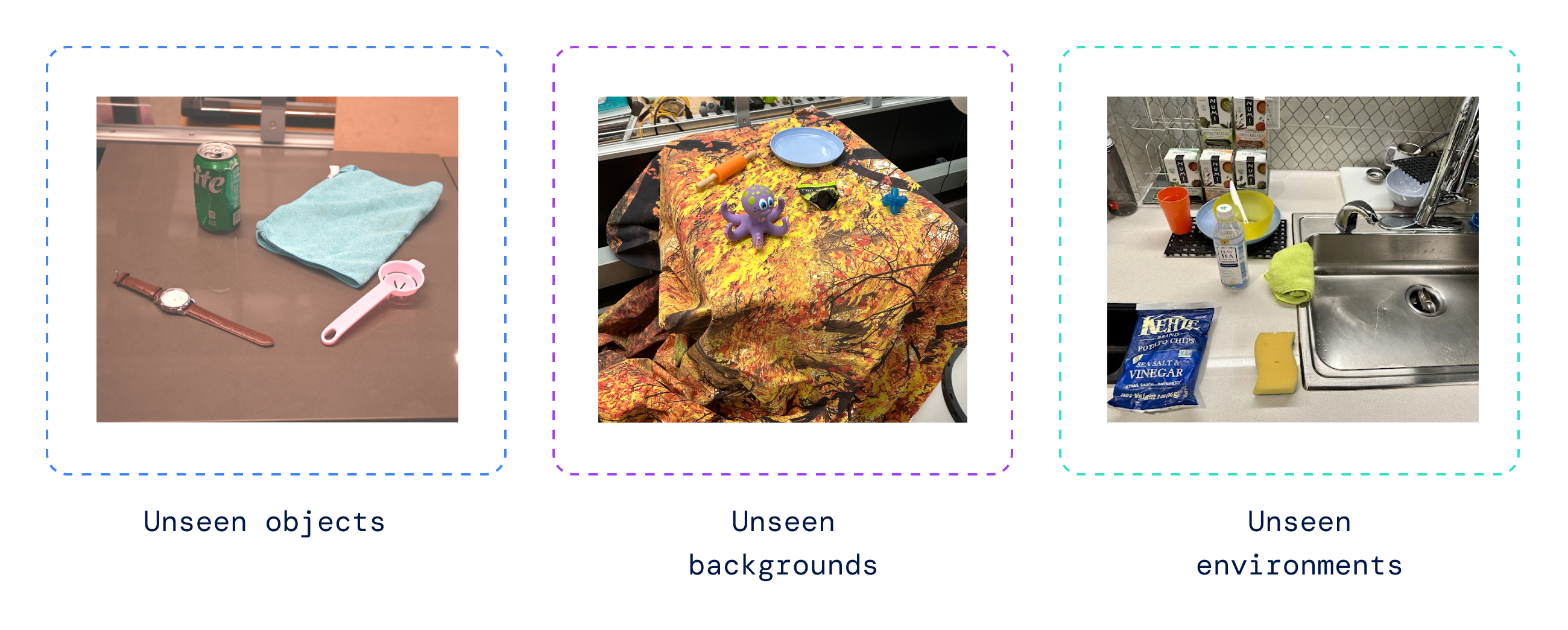

我们还进行了一系列定量评估,从最初的RT-1任务开始,我们在机器人数据中有示例,然后是机器人在不同程度上以前看不见的物体,背景和环境,这些物体,背景和环境需要机器人从VLM预训练中学习泛化。

机器人以前看不见的环境示例,其中RT-2推广到新情况。

RT-2保留了机器人数据中原始任务的性能,并将机器人在以前未见过的场景中的性能从RT-1的32%提高到62%,显示出大规模预训练的可观优势。

此外,我们观察到与在仅视觉任务上预先训练的基线相比,例如VC-1和机器人操作的可重用表示(R3M),以及使用VLM进行对象识别的算法(例如开放世界对象的操作(MOO))的显着改进。

RT-2 在可见的分发任务上实现了高性能,在分发外的不可见任务上优于多个基线。

在开源的机器人任务语言表套件上评估我们的模型,我们在模拟中取得了90%的成功率,比之前的基线(包括BC-Z(72%),RT-1(74%)和LAVA(77%))有了显着改善。

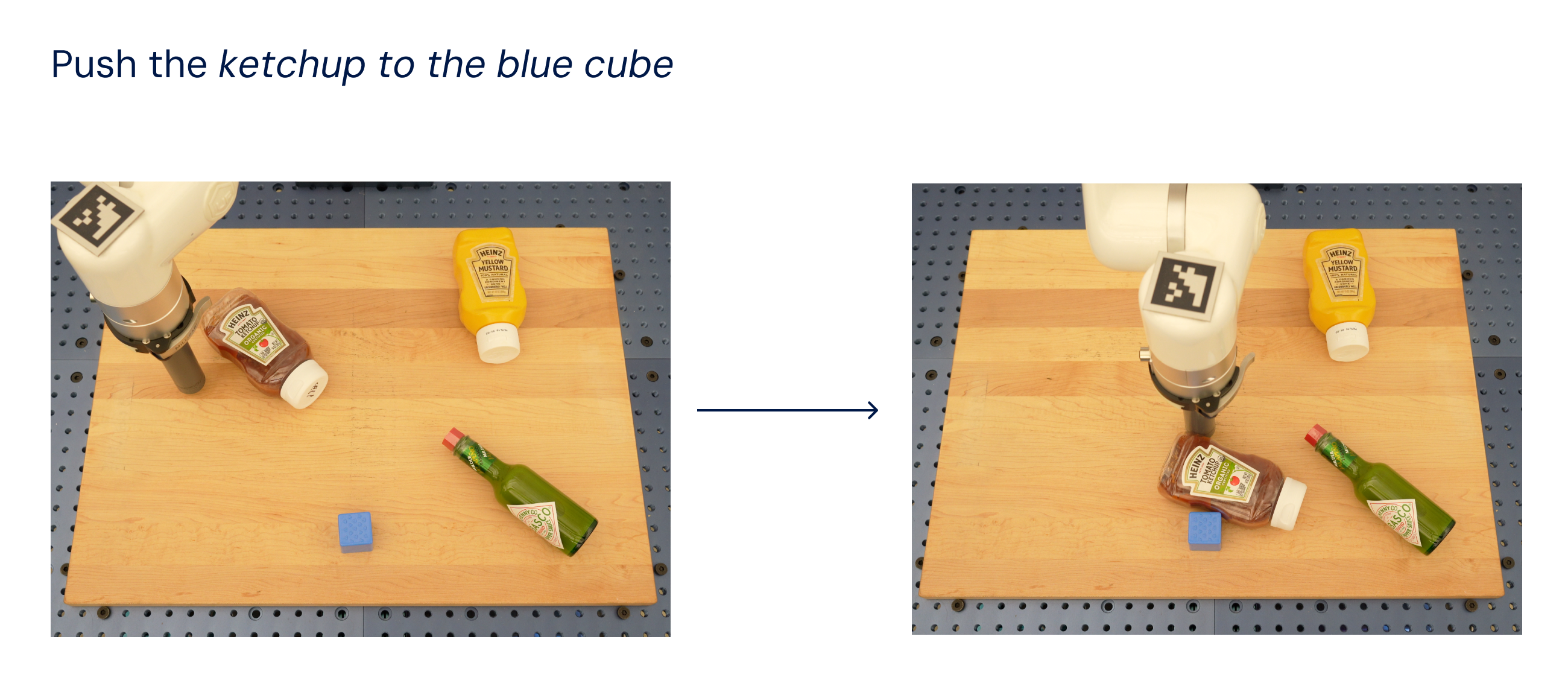

然后,我们在现实世界中评估了相同的模型(因为它是在模拟和真实数据上训练的),并展示了它推广到新对象的能力,如下所示,其中除了蓝色立方体之外,训练数据集中不存在任何对象。

RT-2在真正的机器人语言表任务中表现良好。除了蓝色立方体之外,训练数据中不存在任何对象。

受LLM中使用的思维链提示方法的启发,我们探索了我们的模型,将机器人控制与思维链推理相结合,以便在单个模型中学习长期规划和低级技能。

特别是,我们对RT-2的变体进行了几百个梯度步骤的微调,以提高其结合使用语言和动作的能力。然后,我们扩充了数据,包括一个额外的“计划”步骤,首先用自然语言描述机器人将要采取的行动的目的,然后是“行动”和动作令牌。在这里,我们展示了这种推理和机器人的结果行为的示例:

思维链推理可以学习一个独立的模型,该模型既可以规划长期技能序列,也可以预测机器人动作。

通过此过程,RT-2可以执行更复杂的命令,这些命令需要对完成用户指令所需的中间步骤进行推理。得益于其VLM主干,RT-2还可以从图像和文本命令进行计划,从而实现基于视觉的规划,而目前像SayCan这样的计划和行动方法无法看到现实世界,完全依赖语言。

推进机器人控制

RT-2表明,视觉语言模型(VLM)可以转化为强大的视觉-语言-行动(VLA)模型,通过将VLM预训练与机器人数据相结合,可以直接控制机器人。

通过基于 PaLM-E 和 PaLI-X 的 VLA 的两个实例化,RT-2 导致高度改进的机器人策略,更重要的是,导致显着更好的泛化性能和紧急功能,继承自网络规模的视觉语言预训练。

RT-2不仅是对现有VLM模型的简单有效的修改,而且还显示了构建通用物理机器人的前景,该机器人可以推理,解决问题和解释信息,以在现实世界中执行各种任务。