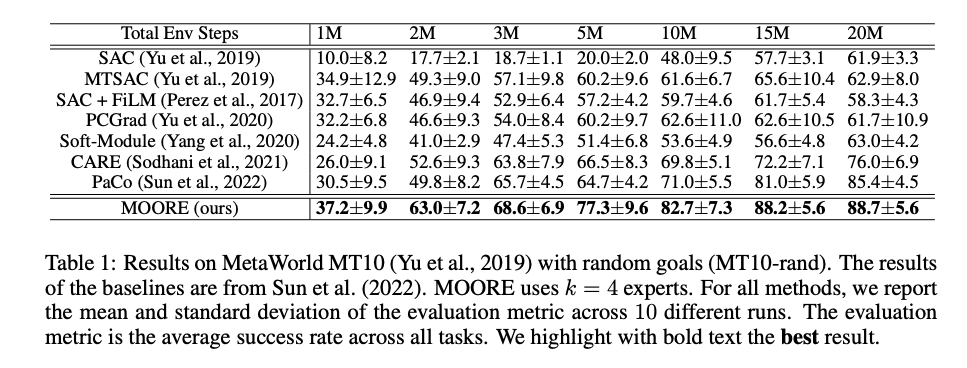

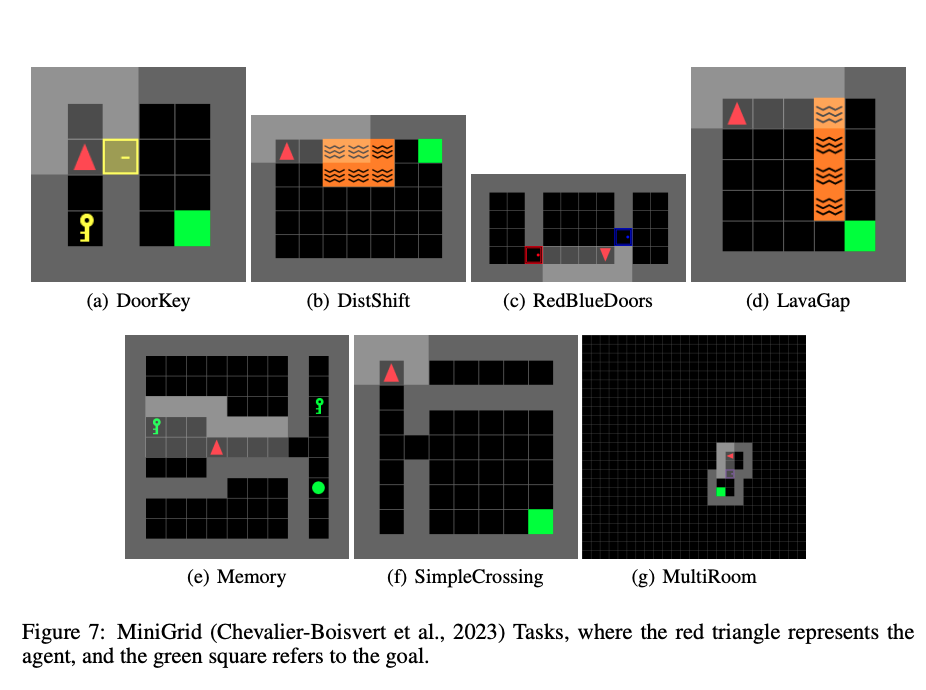

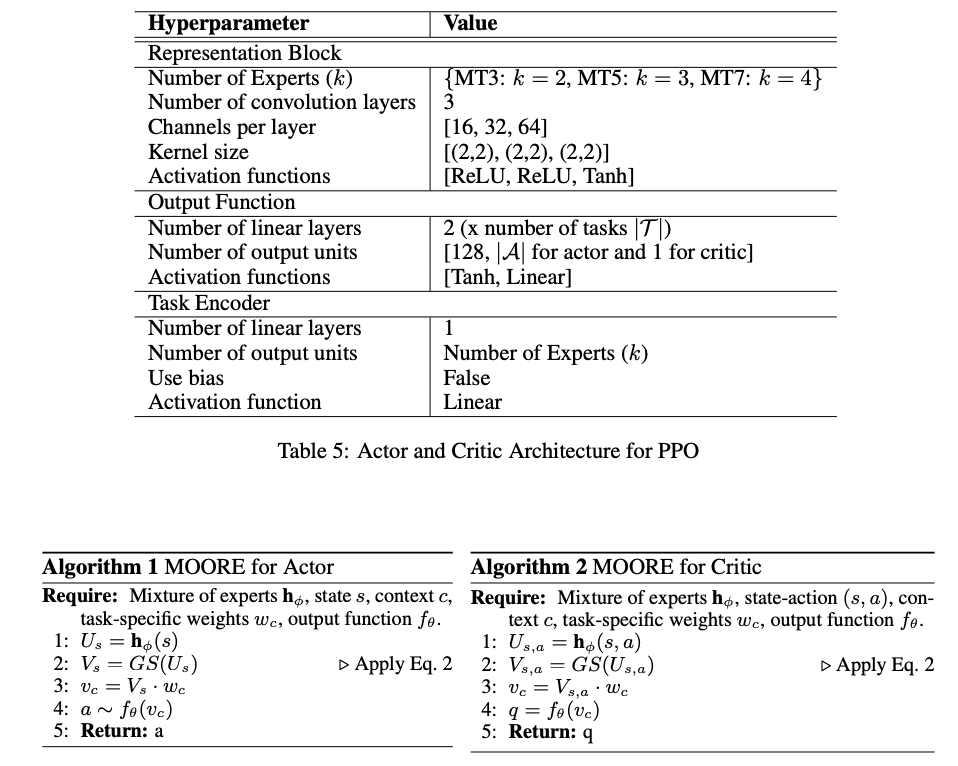

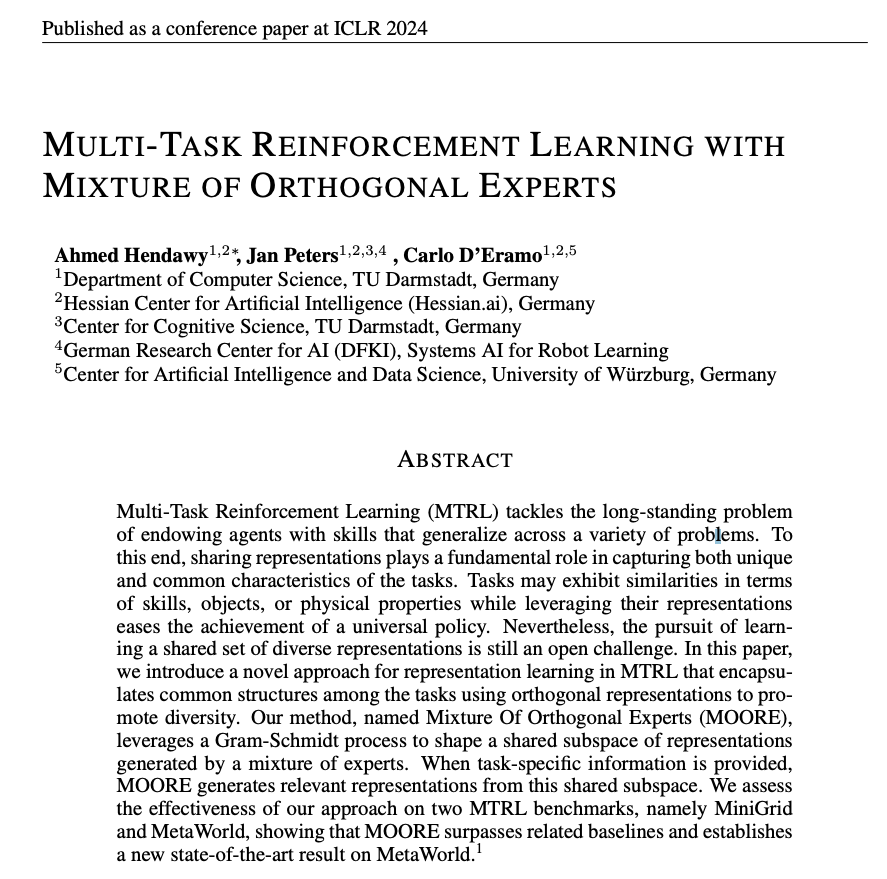

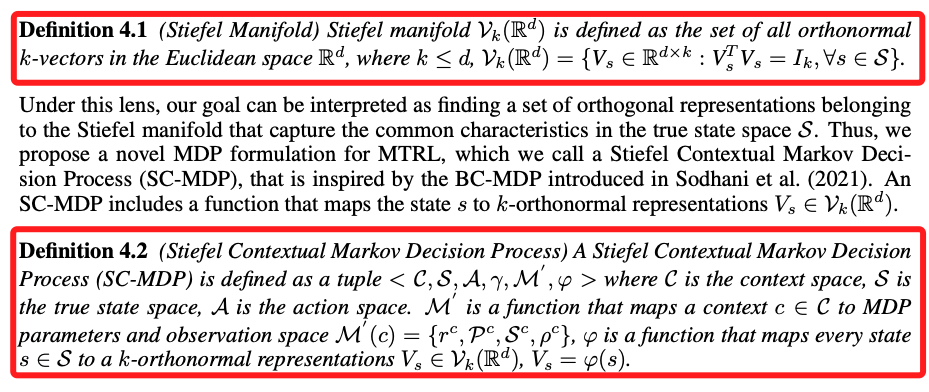

多任务强化学习(MTRL)解决了赋予代理人在各种问题上泛化的技能这一长期存在的问题。为此,共享表示在捕捉任务的独特和共同特征方面发挥着重要作用。任务可能在技能、对象或物理特性方面表现出相似性,而利用它们的表示可以简化通用策略的实现。尽管如此,追求学习一套共享的不同表征仍然是一个悬而未决的挑战。在本文中,我们介绍了一种在MTRL中进行表示学习的新方法,该方法使用正交表示来封装任务之间的公共结构,以促进多样性。我们的方法名为正交专家混合(MOORE),利用Gram-Schmidt过程来形成由专家混合生成的表示的共享子空间。当提供特定于任务的信息时,MOORE从该共享子空间生成相关表示。我们在两个MTRL基准(即MiniGrid和MetaWorld)上评估了我们的方法的有效性,表明MOORE超越了相关基线,并在MetaWorld上建立了新的最先进的结果

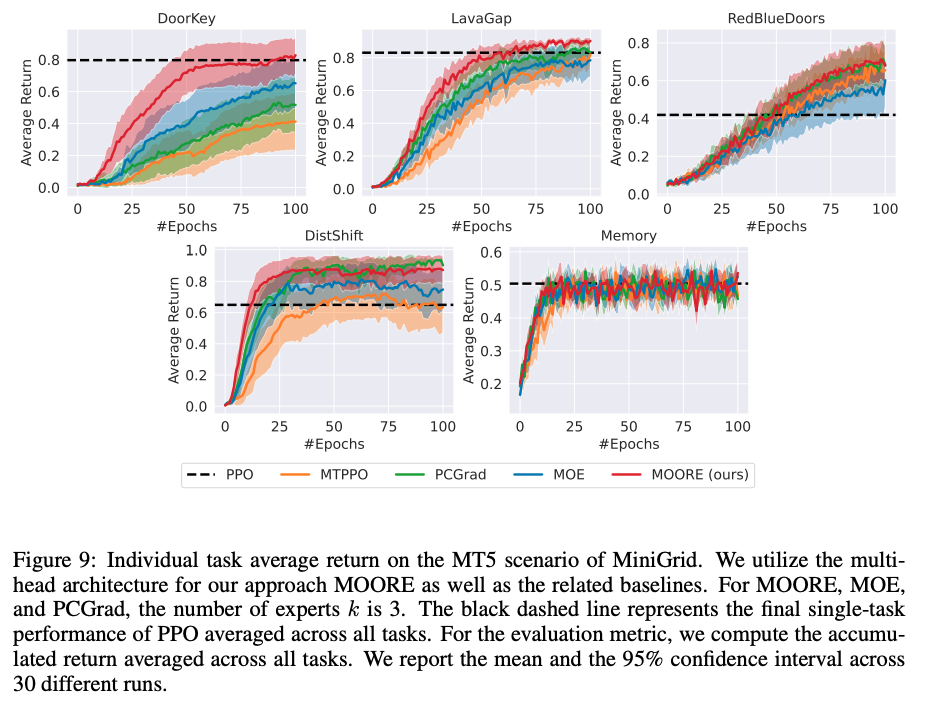

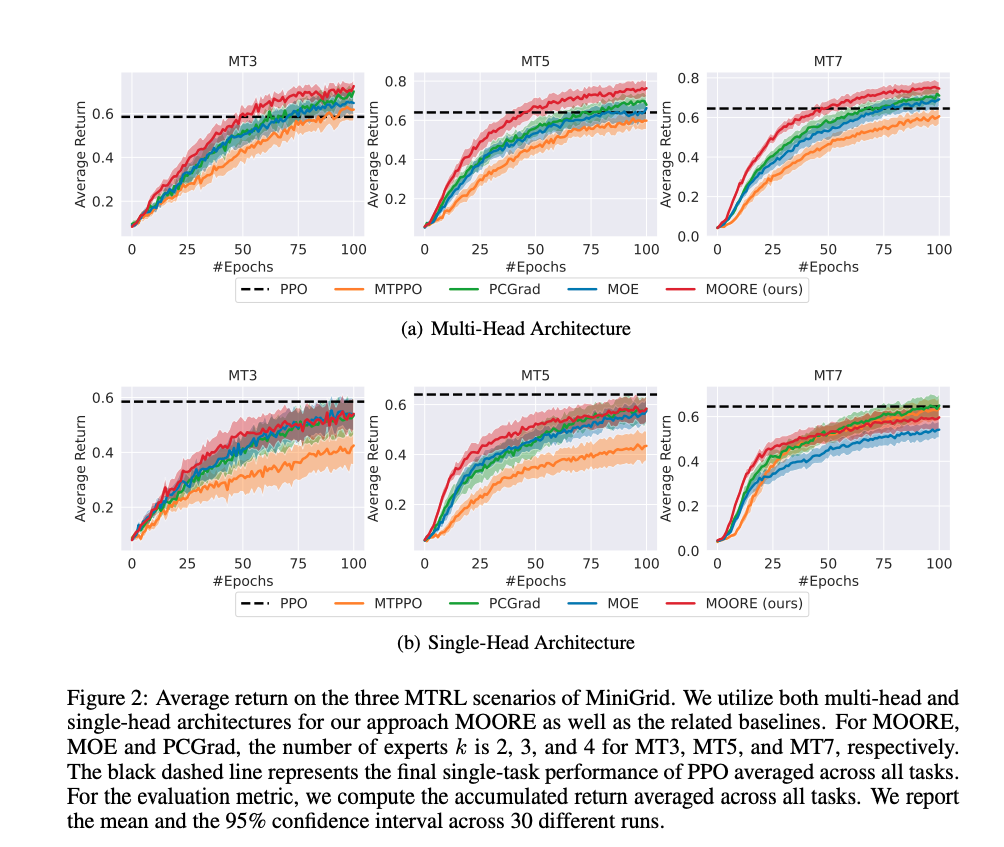

我们有两个理由支持我们的说法:•当使用多头架构时,MOORE在所有3种MiniGrid场景中都优于所有基线。采用多头架构可以解耦所有任务的输出功能,完全消除输出阶段的任务干扰。•在图15中,我们进行了一项消融研究,强调了PCGrad(解决任务干扰的显式MTRL方法)和我们的方法相结合的效果。由于MOORE与PCGrad正交,我们可以很容易地对它们进行集成。本研究表明,MOORE+PCGrad的性能优于MOORE、PCGrad、MOE和MTPPO。然而,多头架构的MOORE仍然优于MOORE+PCGrad,表明PCGrad只能部分减少输出级的干扰,而多头架构的MOORE完全消除了干扰。