离线强化学习算法有望实现数据驱动的强化学习方法,这些方法不需要昂贵或危险的现实世界探索,并受益于预先收集的大型数据集。这反过来可以促进现实世界的应用,以及强化学习研究的更标准化方法。此外,离线RL方法可以为在线微调提供有效的初始化,以克服探索方面的挑战。然而,评估离线强化学习算法的进展需要有效且具有挑战性的基准,这些基准可以捕捉现实世界任务的属性,提供一系列任务困难,并涵盖一系列挑战,包括领域参数(例如,视野长度、奖励稀疏性)和数据参数(例如狭窄的演示数据或广泛的探索数据)。虽然近年来离线强化学习取得了长足的进步,这得益于更简单的基准任务,但最广泛使用的数据集在性能上越来越饱和,可能无法反映现实任务的属性。我们提出了一种新的离线强化学习基准,该基准侧重于基于现实世界机器人系统模型的机器人操纵和运动环境的真实模拟,并包括各种数据源,包括脚本数据、人类远程操作员收集的游戏风格数据和其他数据源。我们提出的基准涵盖了基于状态和基于图像的领域,并支持离线RL和在线微调评估,其中一些任务专门设计为需要预训练和微调。我们希望我们提出的基准将促进离线RL和离线调优算法的进一步发展。包含代码、示例、任务和数据的网站可在https://sites.google.com/view/d5rl

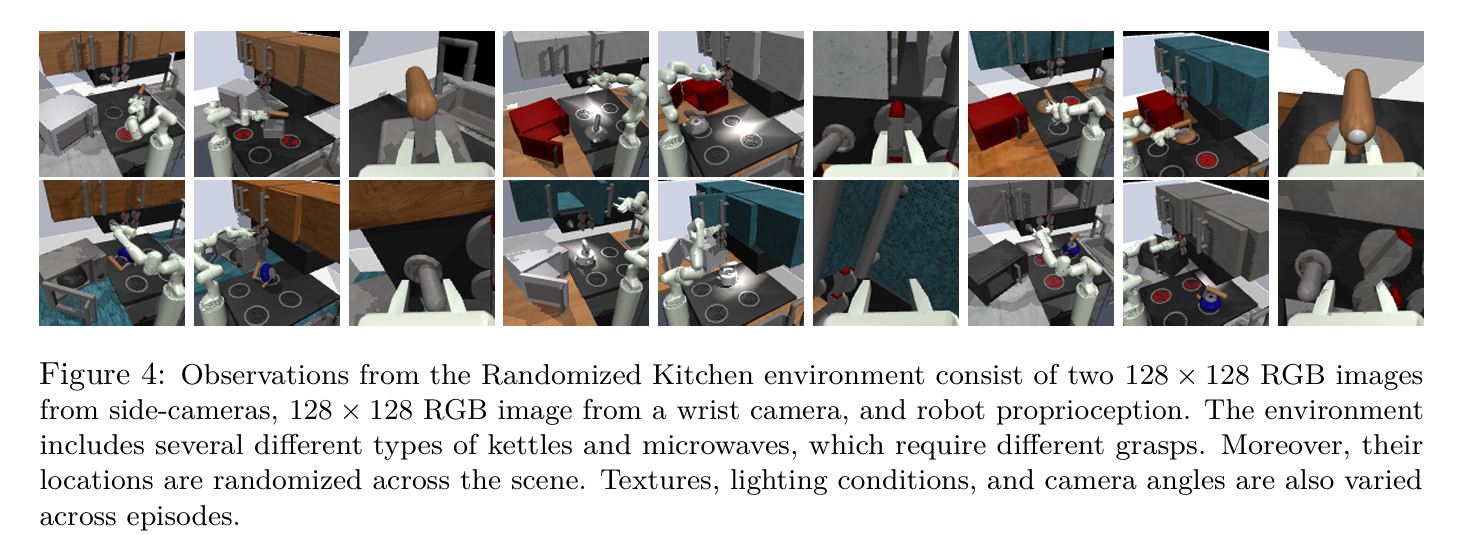

离线强化学习算法有望实现数据驱动的强化学习方法,这些方法不需要昂贵或危险的现实世界探索,并受益于预先收集的数据集(Levine等人,2020;Gulcehre等人,2020)。后者在数据驱动的机器学习的现代尤其重要,在这个时代,对大型数据集的训练一再被证明是有效泛化的关键因素(LeCun等人,2015;Krizhevsky等人,2017),甚至是新兴能力(Wei等人,2022)。此外,离线RL方法可以为在线微调提供有效的初始化,克服探索的挑战,并为适合现实世界的快速在线训练提供有效的公式。然而,尽管在大型预收集数据集上运行的监督学习方法可以有效地评估从真实世界数据中采样的测试集,但在数据上训练的离线RL算法仍必须通过在线交互进行验证,以衡量其有效性,即使在训练过程中不需要在线交互。因此,评估离线强化学习方法的进展需要有效且具有挑战性的基准,这些基准可以在模拟中提供可访问的评估,同时仍然在反映现实世界系统的属性方面提供一定程度的真实性,并涵盖领域参数(例如,视界长度、奖励稀疏性)和数据参数(例如狭窄的演示数据或广泛的探索数据)方面的一系列挑战。虽然近年来离线强化学习取得了长足的进步,这得益于更简单的基准任务,但最广泛使用的数据集在性能上越来越饱和(Fu等人,2020;Gulcehre等人,2019),可能无法反映现实任务的属性,也可能无法涵盖一些最重要的用例,例如从离线初始化开始的在线微调。在这篇论文中,我们提出了一种新的离线RL基准,该基准侧重于基于现实世界机器人系统模型的机器人操纵和运动环境的真实模拟,并包括各种数据源,包括脚本数据、人类远程操作员收集的游戏风格数据和其他数据源。我们提出的基准涵盖了基于状态和基于图像的领域,支持离线RL评估和在线微调评估,其中一些任务专门设计为需要预训练和微调。我们希望我们提出的基准将促进离线强化学习算法和从离线初始化到在线微调的算法的进一步进展。我们在图1中概述了基准中的环境,其中包括现实世界机器人平台的真实模拟模型,如A1四足动物和弗兰卡机械臂。除了提供比先前工作更具挑战性和最新的任务和数据集范围(Fu等人,2020;Gulcehre等人,2019)外,我们的任务还涵盖了一系列先前基准中很少涵盖的因素,或者很少结合出现的因素。A1任务专门评估在线微调:这些任务的设计是,离线初始化应提供基本但低性能的能力(例如,不下降),而在线微调是实现最大有效步态所必需的。视觉Franka厨房环境评估视觉感知、环境可变性(通过随机化实现)以及使用真实人类通过远程操作收集的“游戏风格”多样化数据的能力。视觉WidowX拾取和放置环境评估了将操纵技能的不同阶段“缝合在一起”以完成多阶段行为的能力。虽然之前的数据集评估了缝合(例如,D4RL中的AntMaze任务(Fu等人,2020)),但很少在广泛接受的基准中结合视觉感知进行评估。我们全面描述了我们提出的任务和相应的数据集,以及我们在基准测试中评估的许多广泛使用的离线RL和在线微调方法的高质量实现。我们表明,当前的RL方法可以而且确实在运动等低维任务上表现良好,但不能可靠地扩展到现实的机器人场景。在我们的实验中,所有当前的强化学习算法在涉及更复杂运动、将多个目标链接在一起(“拼接”)或现实分布变化的现实机器人任务上都不能可靠地优于简单的BC方法。事实上,它们没有表现出任何这些品质,即有效的动态规划或鲁棒性。我们认为,这表明当前的强化学习方法不适合大规模逼真的机器人场景,在这些场景中,使用大容量模型(如RT-*系统)的简单模仿学习。我们已经构建了我们的任务和数据集,为这些潜在应用的新算法提供了一个测试平台,同时仍然保持了简单性、速度和可访问性(我们所有的实验在单个GPU上只需要不到12个小时)

数据集:为了提供该领域的离线训练数据,我们手动收集了近20小时的人类遥操作数据:1。演示:我们从一位经验丰富的远程操作员那里收集了500个专家级演示,用于微波炉、水壶、电灯开关和滑动柜任务(与第5.2.1节中的“混合”数据集相同)。该数据集适用于测试表示学习方法的能力和基准模拟学习算法。

2.游戏:我们收集了1000集的数据集,这些数据集不是来自不同技能水平的多个操作员的任务导向型数据集。这些事件由无向环境交互组成,涉及以随机顺序和位置操纵2到6个对象。这些事件是由几个具有不同经验水平的远程操作员收集的,这在行为和执行抓握的质量方面都在数据中引入了显著的多模态。

3.次优专家:我们还包括一个由500集组成的次优专家数据集,由缺乏经验的远程操作员收集,但我们在这项工作中没有明确地对其进行基准测试。任务:在演示数据集上,代理在与该演示对应的任务上进行评估。在Play数据集上,类似于第5.2.1节,我们考虑两个任务:

1.混合:与之前类似,在这个任务中,我们需要操纵微波炉、水壶、电灯开关和滑动橱柜物体。然而,除了随机厨房带来的表示学习和鲁棒性挑战外,代理还需要从不同质量的不同数据中学习。另一个挑战是,虽然有几个事件可以操纵所有四个对象,但它们的顺序不同,这给具有多模态解决方案的动态规划带来了挑战。

2.部分:与之前类似,代理人需要操纵微波炉、水壶、底部燃烧器旋钮和电灯开关对象,这些对象在离线数据中从未在同一事件中解决过