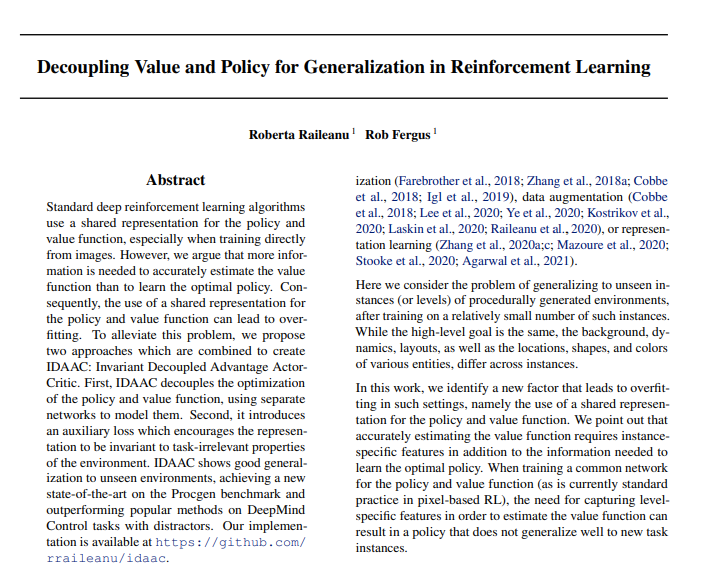

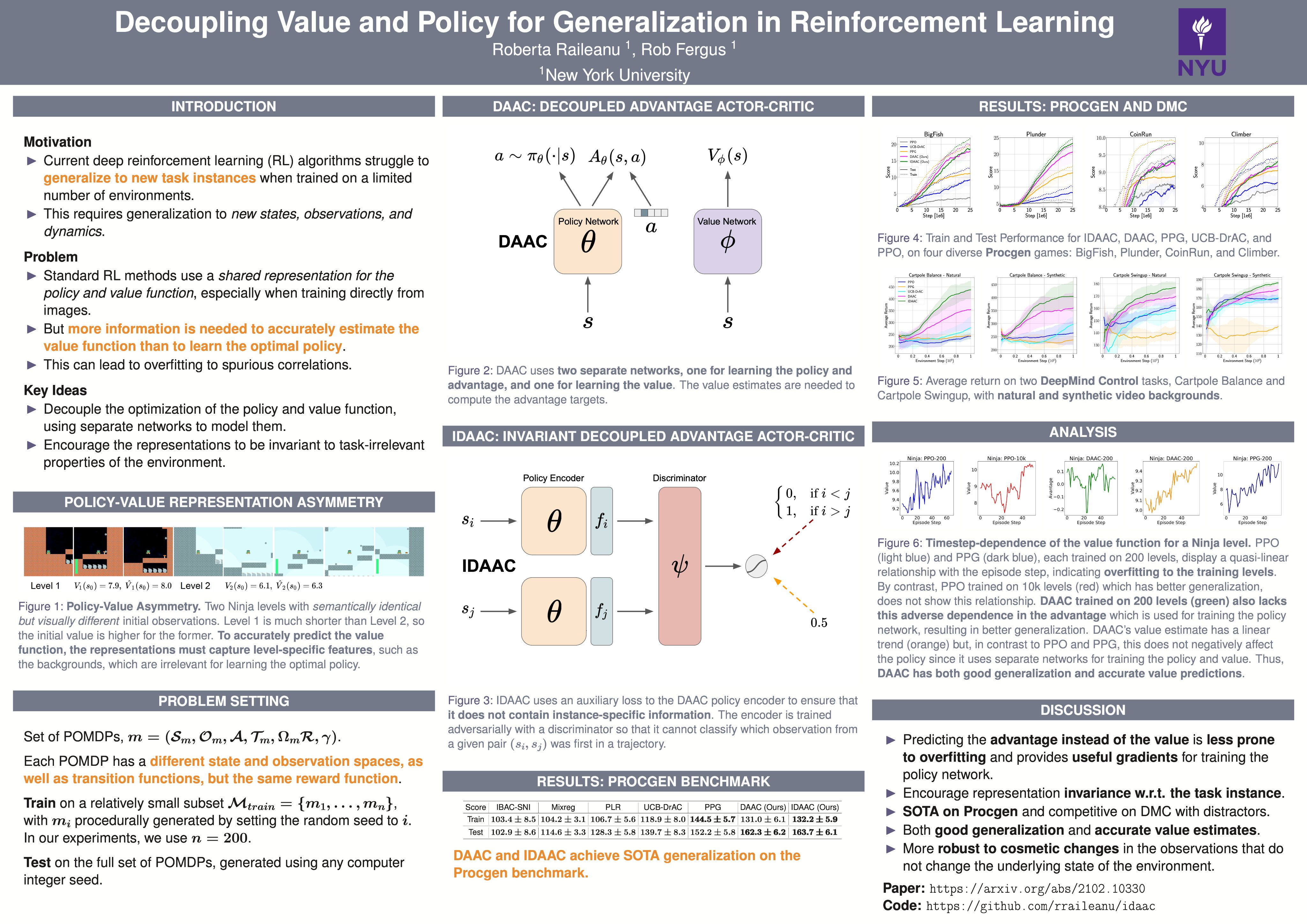

标准的深度强化学习算法使用共享的策略和值函数表示,尤其是在直接从图像训练时。 然而作者认为准确估计价值函数需要更多的信息,而不是学习最优策略。 因此,对策略和价值函数使用共享表示可能会导致过度拟合。 为了缓解这个问题提出了两种结合起来创建 IDAAC 的方法:Invariant Decoupled Advantage ActorCritic。 首先,IDAAC 将策略和价值函数的优化解耦,使用单独的网络对其进行建模。 其次,它引入了辅助损失,鼓励表示对环境的任务无关属性保持不变。 IDAAC 表现出对未知环境的良好泛化,在 Procgen 基准测试中达到了新的最新技术水平,并且在带有干扰项的 DeepMind 控制任务上的表现优于流行的方法。

Cite

If you use this code in your own work, please cite our paper:

@article{Raileanu2021DecouplingVA,

title={Decoupling Value and Policy for Generalization in Reinforcement Learning},

author={Roberta Raileanu and R. Fergus},

journal={ArXiv},

year={2021},

volume={abs/2102.10330}

}