Actor-Critic methods结合了value-based methods和policy gradient的优势,今天我们跟着2012年的一篇综述文章"A Survey of Actor-Critic Reinforcement Learning: Standard and Natural Policy Gradients." 梳理一下它的发展过程,回顾一下经典算法。

原文传送门:A survey of actor-critic reinforcement learning: Standard and natural policy gradients

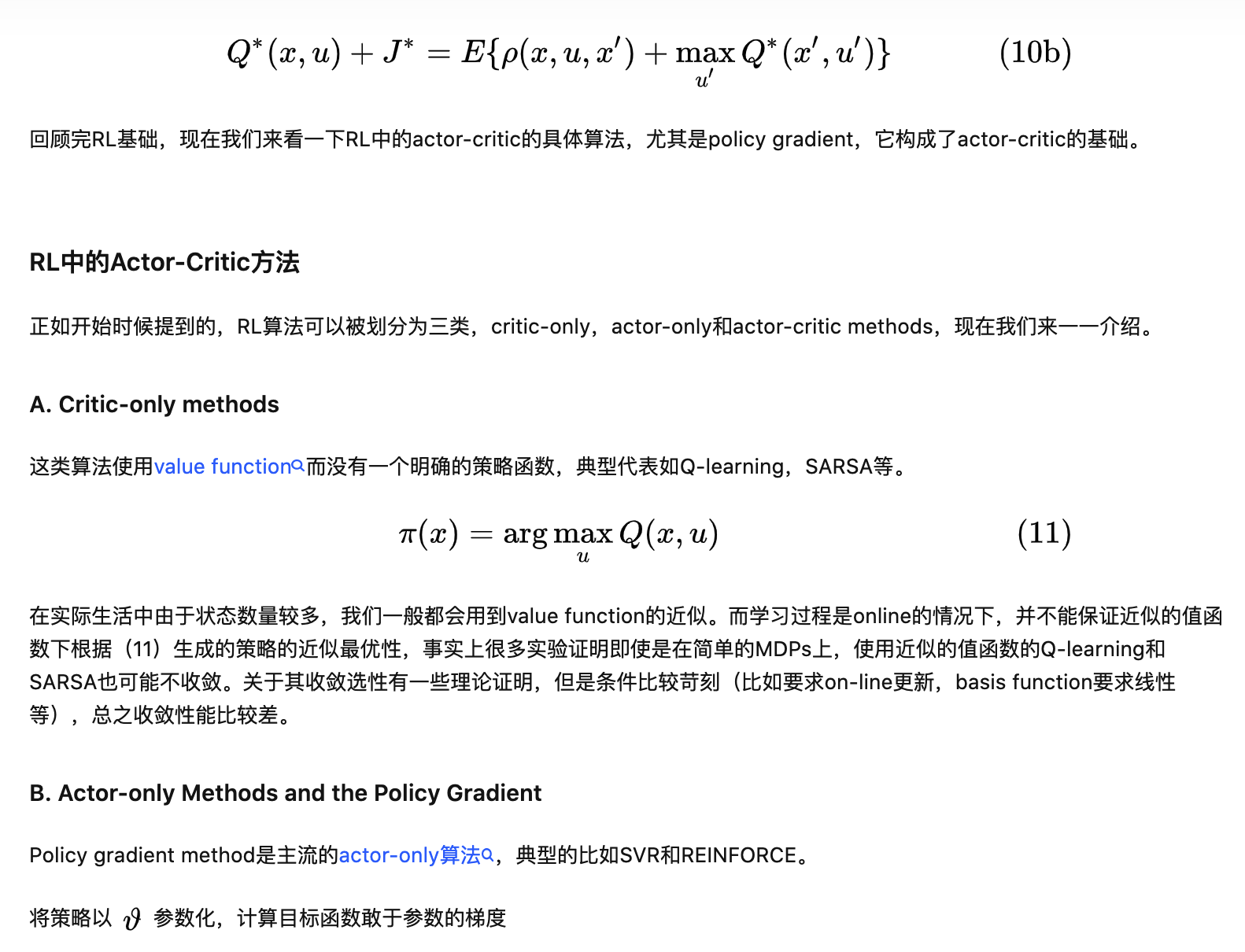

我们可以把RL的算法分为三类:actor-only,critic-only以及actor-critic methods。

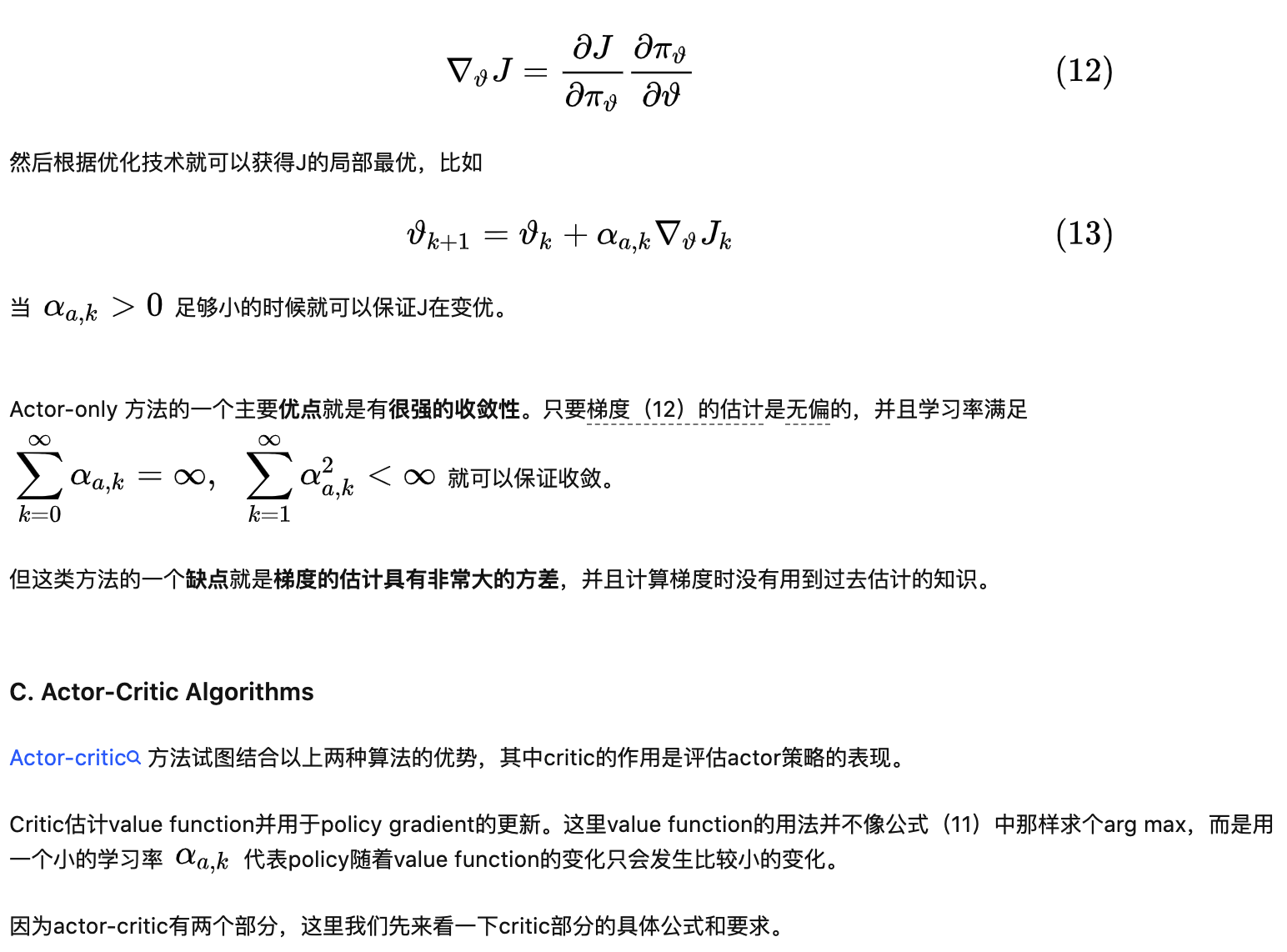

Actor-only methods(policy gradient)直接学习一个参数化的策略,优点是可以用于连续的动作空间,但是其优化算法(policy gradient)通常具有很高的variance,导致学习很慢。

Critic-only methods使用temporal difference learning,学习期望收益时variance较低。选择最优action的方法通常是greedy,这个计算是expensive的,尤其动作空间是连续的情况。并且收敛性比较差。

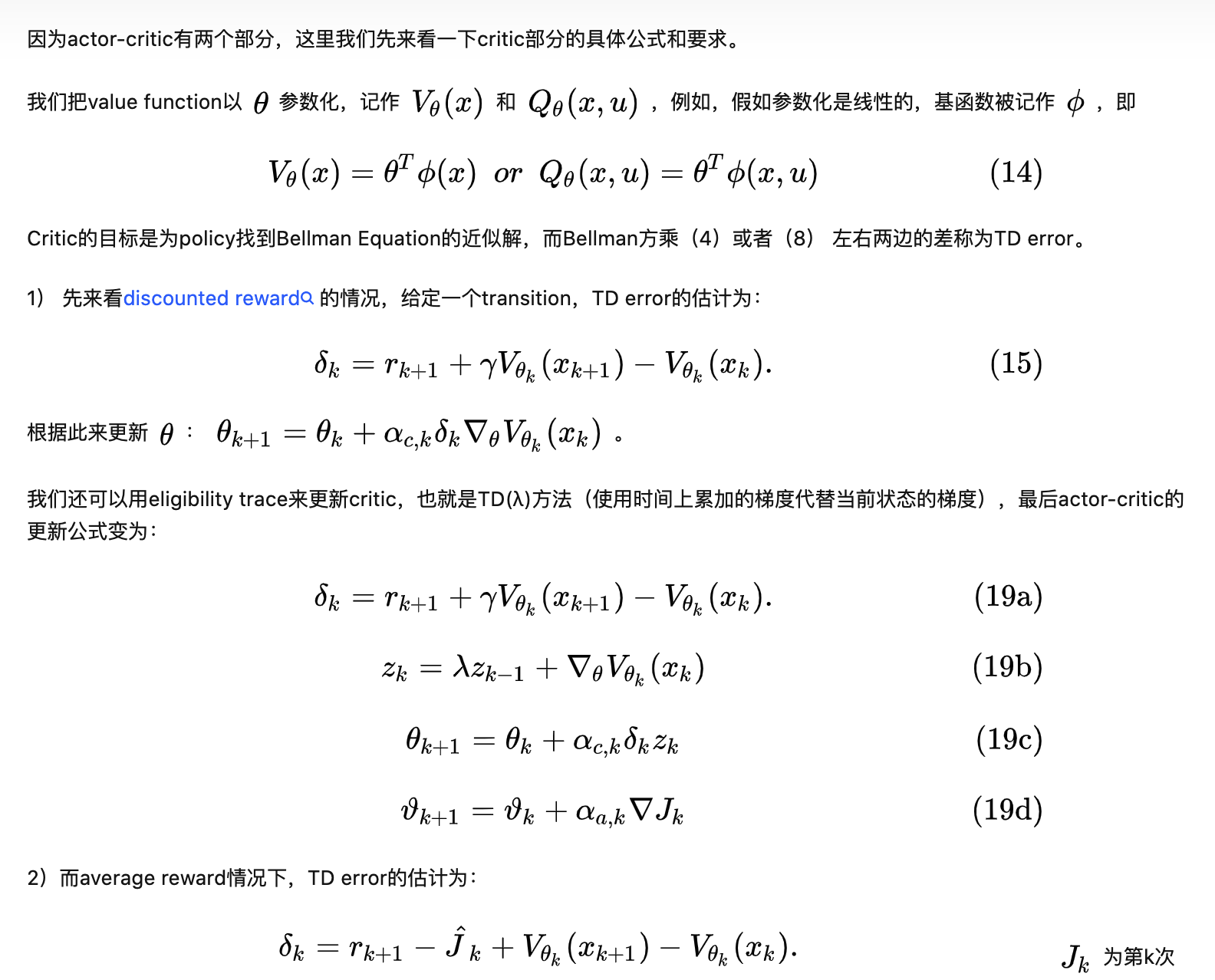

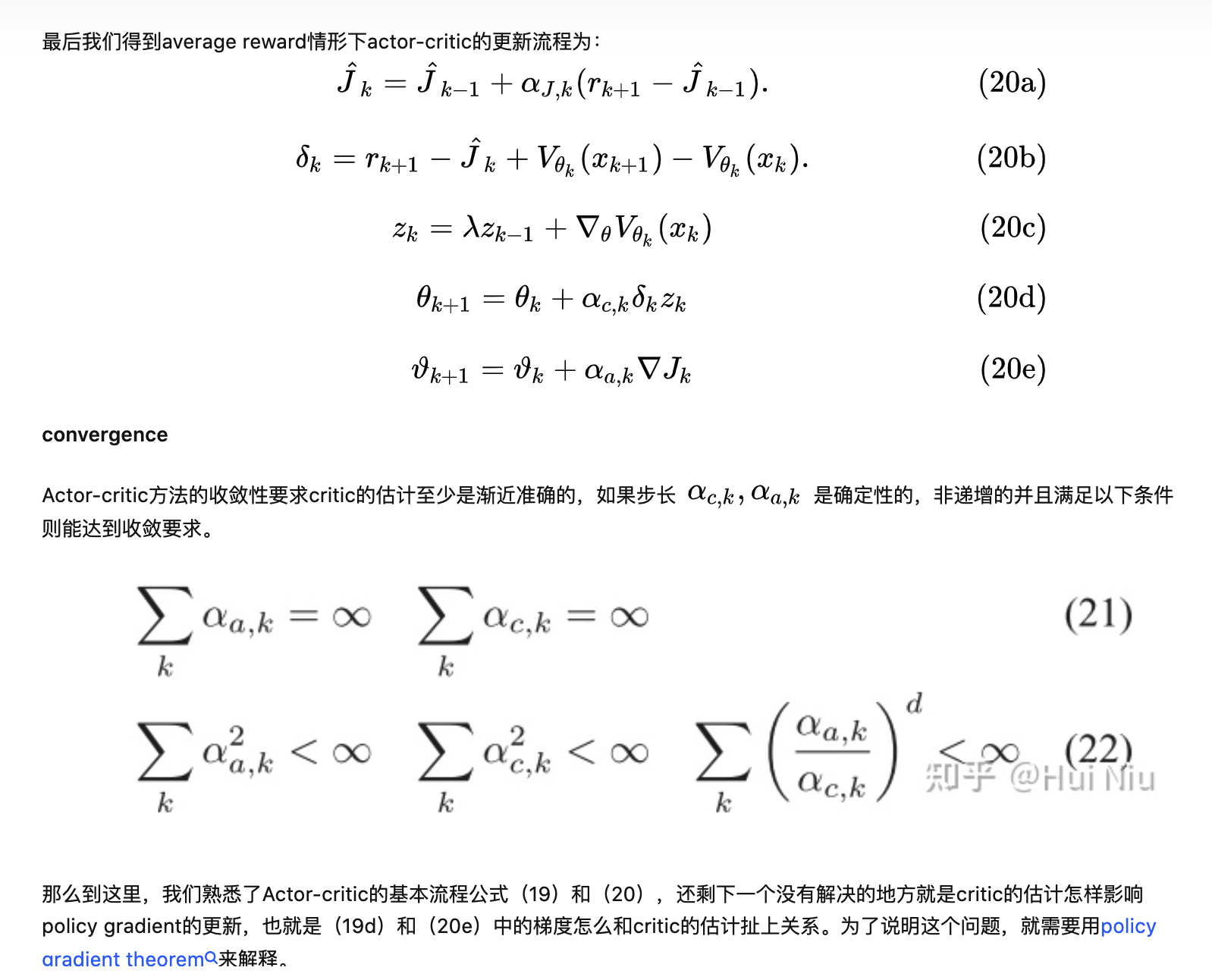

Actor-critic methods结合了二者的优势,使用critic的值估计为actor提供了一个low-variance knowledge of its performance,使得policy gradient的方差减小,从而加速了学习。但是policy gradient的低方差是以开始时critic估计并不准确增大了bias为代价的。actor-critic算法通常比critic-only算法具有更好的收敛性。

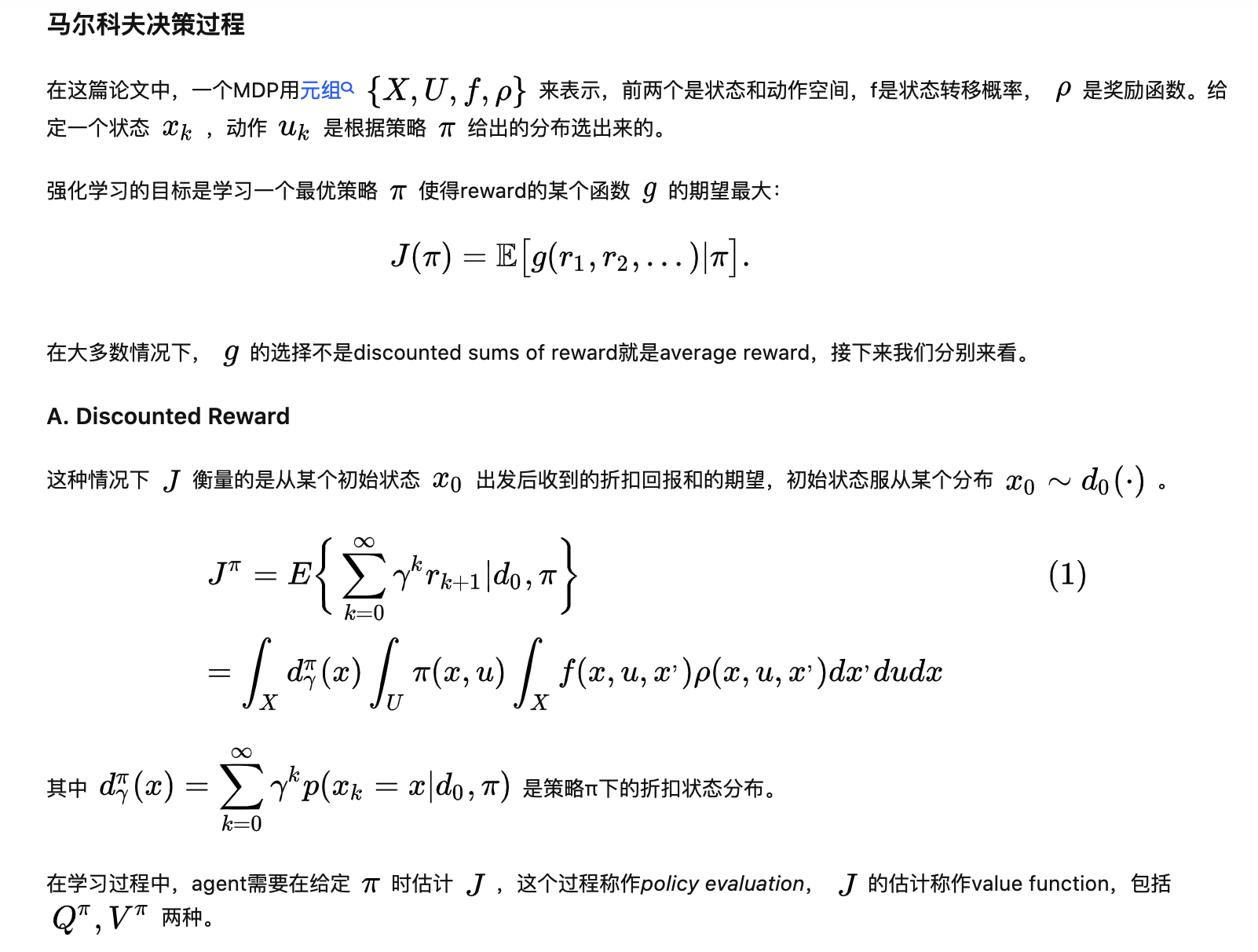

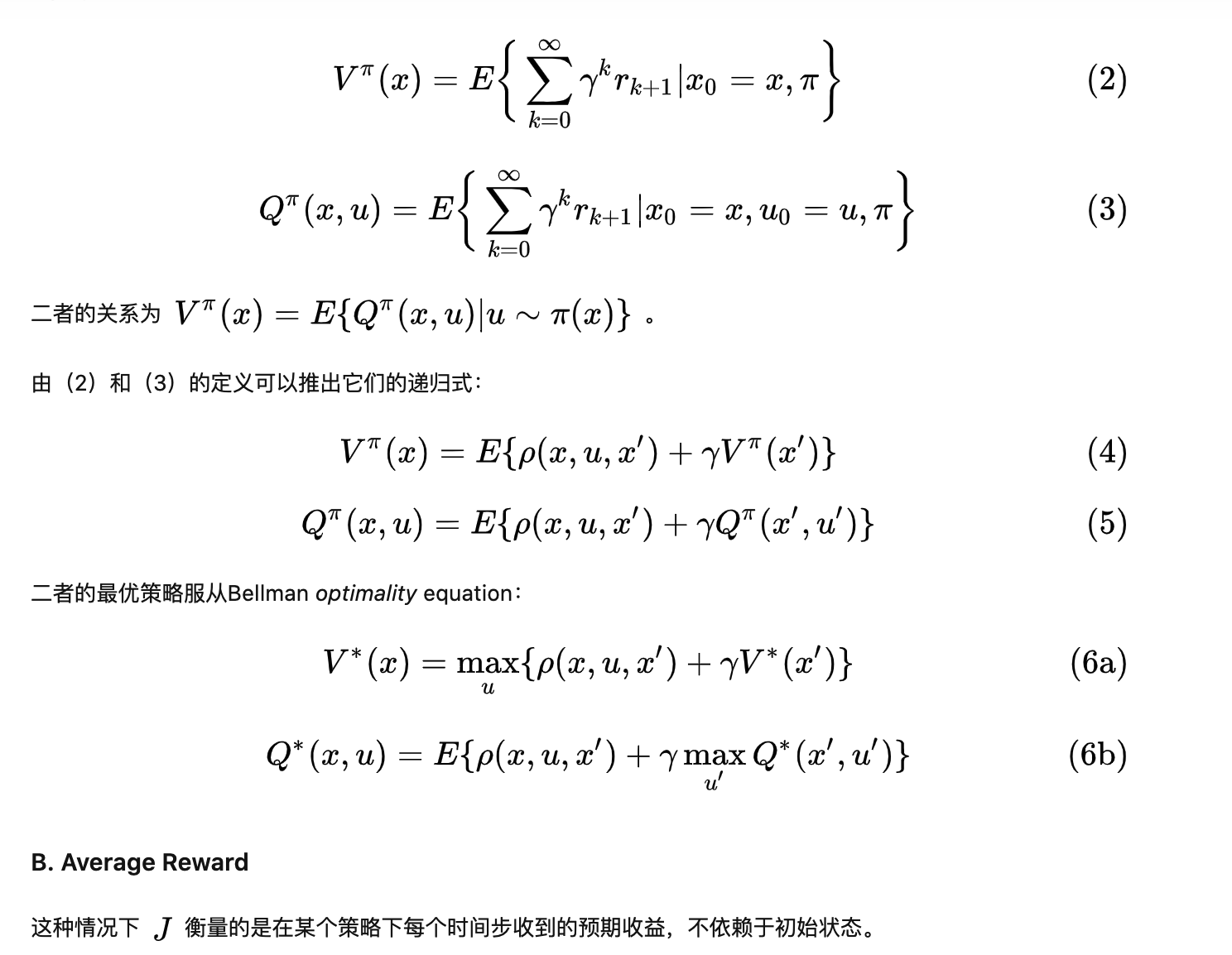

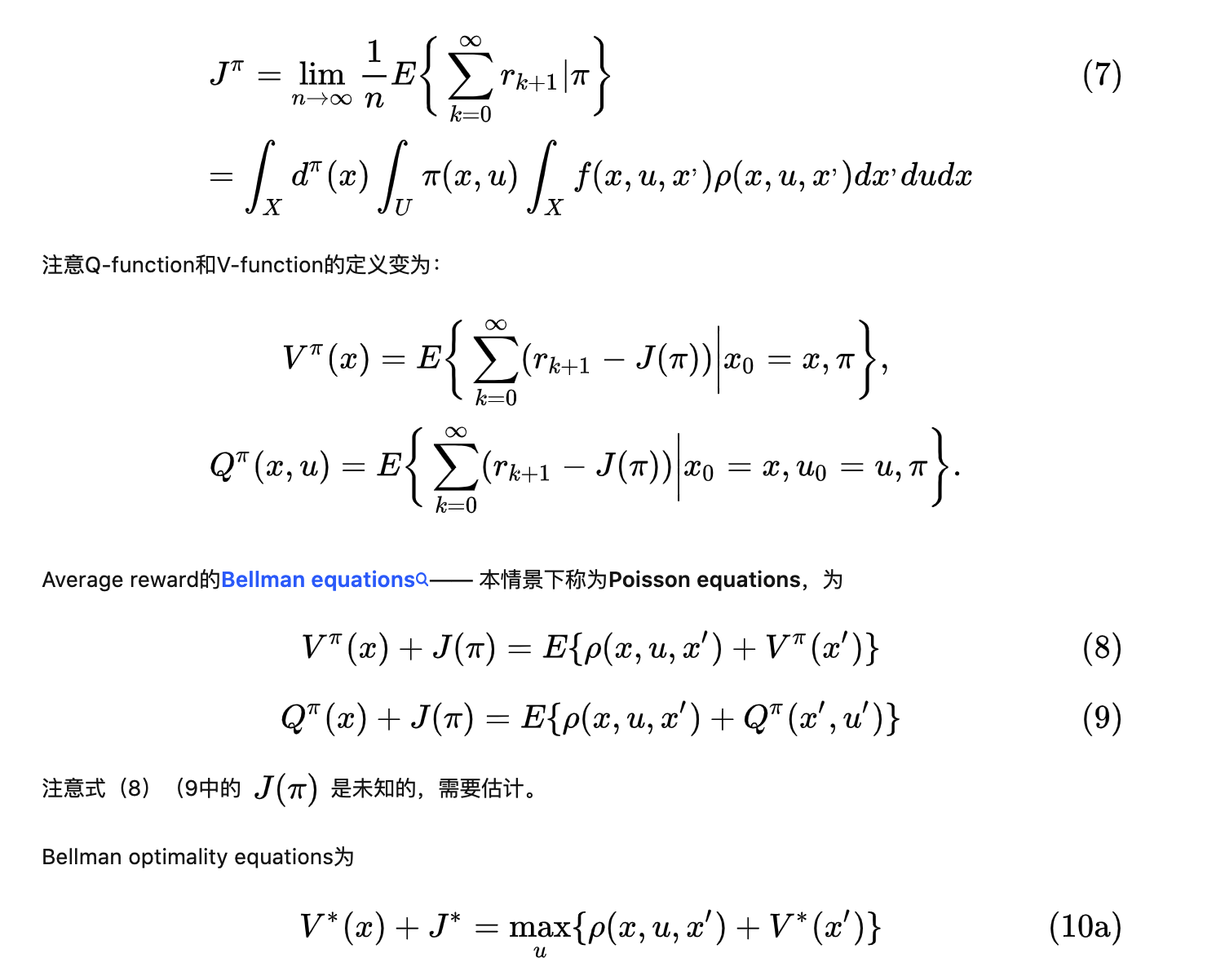

在回顾这些算法之前,我们首先回顾一下RL问题的数学定义和Bellman方程。

参考

[1] Grondman, I. , et al. "A Survey of Actor-Critic Reinforcement Learning: Standard and Natural Policy Gradients." IEEE Transactions on Systems Man & Cybernetics Part C 42.6(2012):1291-1307.