整理了一下最近的阅读列表,对强化学习在金融量化中的应用做一个梳理归纳。

前言

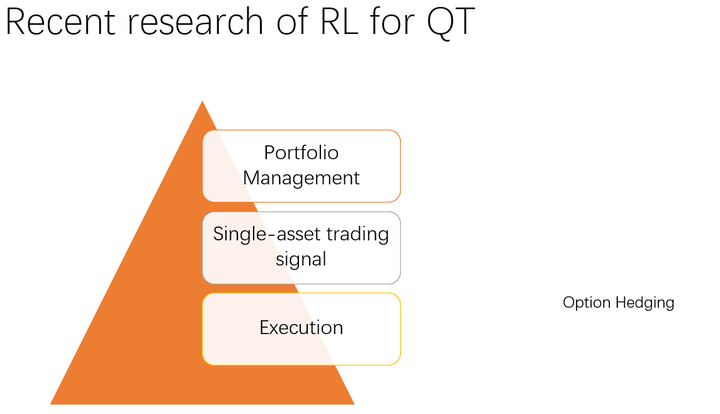

目前学界RL在量化交易里面的应用,大致分为4种:Portfolio Management(投资组合管理),Single-asset trading signal (单资产交易信号),Execution(交易执行)以及Option hedging(期权对冲和定价)。其中PM一般是低频交易,单股交易信号一般是中高频,交易执行一般是高频tick级数据上的策略,至于期权定价则是理论和实践统一起来的工作。今天主要对PM做一些总结和介绍,单资产和交易执行可以参考师兄

@张楚珩

的总结,期权对冲和定价后续补充。

1. RL in Portfolio Management (PM)

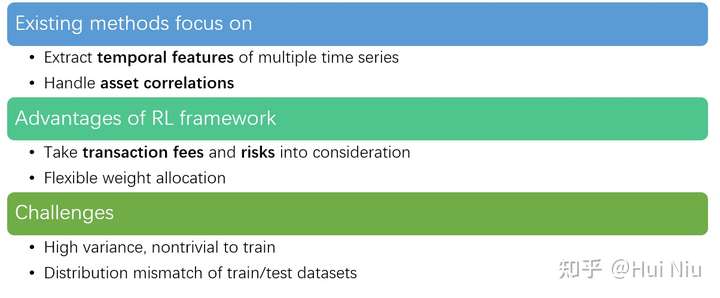

Portfolio Management(投资组合管理)是通过灵活分配资产权重获得更高超额收益的问题。现实中的应用例子比如选股和指数增强基金。一般的解决方案是对股票的涨价潜力进行打分,买入具有上涨潜力的股票并增加权重,卖出可能跌或者相对弱势的股票。这是一个多时间序列(Multiple Time Series)上的权重再分配问题。

强化学习(RL)在此类问题中有2个优势:

RL的目标设定直接且灵活,可以将手续费和风险考虑进去;而监督学习通常是对短期利润贪婪的,可能频繁换仓导致风险和高手续费的问题。

RL直接生成权重,可以灵活地分配权重;而利用监督信号生成策略的规则通常是人规定的。

因此,使用RL框架确实有潜力在PM问题中获得表现更加优秀的策略。但是使用RL解决PM问题也有一些比较棘手的挑战:

一方面RL算法本身就有高方差不容易训练的问题,可能会对超参数比较敏感,结果的安全性和稳定性堪忧。

另一方面,由于RL可以尝试很多权重分配的可能,将奖励信号从多资产的向量变成一个标量,似乎“抹平”了一些信息,可能需要更多的尝试才能获得比较好的结果,训练结果如何令人担忧。(这个观点来源于导师,他认为做好单一资产的预测都不容易,更何况直接的优化)

最后是做量化问题时都要面临的挑战,训练集和测试集分布差异较大的问题。学界研究PM问题使用的是跨度长达数年的低频数据,这个问题尤为严重。

考虑到多资产序列比单一资产序列含有更多可以挖掘信息,现有的方法不仅仅在时间维度上抽取特征,还很关注资产之间的相关关系。最近发表的文章创新点都在于网络结构的设计上,使用最新的监督学习领域的进展抓取多资产序列的时间和空间特征。

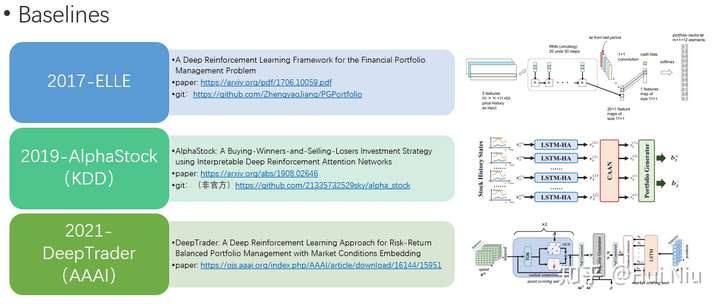

比较典型的两篇baseline是 AlphaStock(2019) 和 DeepTrader(2021)。

还有一些比较新的文章放在下面供大家参考:

Shi, Si, et al. "XPM: An Explainable Deep Reinforcement Learning Framework for Portfolio Management." Proceedings of the 30th ACM International Conference on Information & Knowledge Management. 2021.

Marzban, Saeed, et al. "WaveCorr: Correlation-savvy Deep Reinforcement Learning for Portfolio Management." arXiv preprint arXiv:2109.07005 (2021).

Zhang, Yifan, et al. "Cost-sensitive portfolio selection via deep reinforcement learning." IEEE Transactions on Knowledge and Data Engineering (2020).

Gao, Ziming, et al. "Application of deep q-network in portfolio management." 2020 5th IEEE International Conference on Big Data Analytics (ICBDA). IEEE, 2020.

Sato, Yosuke, and Jianwei Zhang. "Modeling Low-risk Actions from Multivariate Time Series Data Using Distributional Reinforcement Learning." 2020 11th International Conference on Awareness Science and Technology (iCAST). IEEE, 2020.

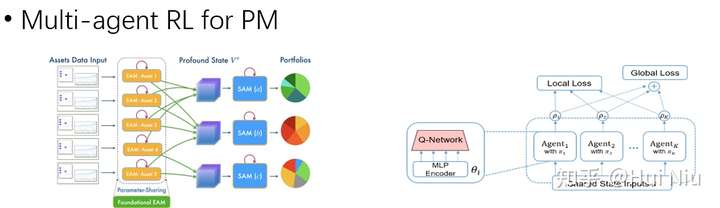

另外近来也有一些Multi-Agent RL在PM问题上的应用。大的投资公司通常有很多不同的投资经理可以分散风险,效仿此想法,使用多智能体RL生成风格不同的资产组合可以在高收益的情况下分散风险。

这个领域做的人比较少,目前只找到3篇文章

Lee, J., Kim, R., Yi, S. W., & Kang, J. (2020). MAPS: multi-agent reinforcement learning-based portfolio management system. arXiv preprint arXiv:2007.05402.

Huang, Z., & Tanaka, F. (2022). MSPM: A modularized and scalable multi-agent reinforcement learning-based system for financial portfolio management. PloS one, 17(2), e0263689.

AbdelKawy, R., Abdelmoez, W. M., & Shoukry, A. (2021). A synchronous deep reinforcement learning model for automated multi-stock trading. Progress in Artificial Intelligence, 10(1), 83-97.

同时,最近还有一些研究,针对测试集和训练集数据分布不同的问题,对RL-PM的算法进行了改进,达到更好的泛化性能和鲁棒性。

主要有两种技术,一种是对抗学习,对模型进行一定攻击;另一种是采样,对数据进行更灵活的采样。

参考文献整理在这里:

Adversarial Learning

Liang, Z., Chen, H., Zhu, J., Jiang, K., & Li, Y. (2018). Adversarial deep reinforcement learning in portfolio management. arXiv preprint arXiv:1808.09940.

Chen, Y. Y., Chen, C. T., Sang, C. Y., Yang, Y. C., & Huang, S. H. (2021). Adversarial attacks against reinforcement learning-based portfolio management strategy. IEEE Access, 9, 50667-50685.

Feng, F., Chen, H., He, X., Ding, J., Sun, M., & Chua, T. S. (2018). Enhancing stock movement prediction with adversarial training. arXiv preprint arXiv:1810.09936.

Adaptive Sampling

Miao, Y. H., Hsiao, Y. T., & Huang, S. H. (2020, December). Portfolio Management based on Deep Reinforcement Learning with Adaptive Sampling. In 2020 International Conference on Pervasive Artificial Intelligence (ICPAI) (pp. 130-133). IEEE.

Huang, S. H., Miao, Y. H., & Hsiao, Y. T. (2021). Novel Deep Reinforcement Algorithm With Adaptive Sampling Strategy for Continuous Portfolio Optimization. IEEE Access, 9, 77371-77385.

2. Single-asset trading signal

单资产的交易信号问题是指对单一资产进行买卖操作以获得比单纯持有更高利润的问题。监督学习在这类问题中取得了比较大的成功。

前面介绍的PM问题进来的研究热点在于时空关系的发掘方面,并没有很多RL算法设计上的独特创新。事实上RL独特的reward设计在2000-2006年左右研究得比较多,当时受制于算力,一般都还是单一资产的交易问题上进行应用。这部分在参考文章【1】中有比较详细的介绍,我总结归纳如下,感兴趣的小伙伴可以去看参考文献【1】。

参考 @张楚珩 的文章

参考 @张楚珩 的文章

小结

RL在量化交易中的应用是非常有潜力的,当然也面临一些挑战。更重要的也许是如何灵活的设计问题和应用模型。3 交易执行和4 期权定价的内容下次更新。欢迎推荐有趣的文章补充上面的reading list~有问题评论区交流呀。

参考

【文献调研】强化学习+资产组合/交易执行 - 张楚珩

【文献调研】算法交易相关文献汇总 - 张楚珩